Oft scheitert die Interaktion mit Sprachmodellen an einer falschen Erwartungshaltung: Wir setzen voraus, dass die KI unsere unausgesprochene Intention versteht. Doch ohne klaren Referenzrahmen agiert das System im luftleeren Raum. Ein Blick auf die Architektur moderner LLMs zeigt, dass sie primär Muster erkennen und fortführen. Fehlt das Muster, sinkt die Qualität. Hier greift das Prinzip des Few Shot Prompting. Es ist der logische Schritt weg vom reinen Befehl hin zur strukturierten Kontext-Gabe, die dem Modell zeigt, wie gedacht werden soll, nicht nur was getan werden muss.

Was ist Few Shot Prompting?

Few Shot Prompting bezeichnet eine spezifische Methode im Prompt Engineering, bei der dem Sprachmodell (LLM) innerhalb der Eingabeaufforderung (Prompt) mehrere Beispiele – sogenannte „Shots“ – präsentiert werden. Diese Beispiele demonstrieren die gewünschte Aufgabe exemplarisch und geben dem Modell ein klares Muster für den erwarteten Output vor.

Im Kontext der Künstlichen Intelligenz und speziell im Bereich NLP (Natural Language Processing) fungiert diese Technik als Brücke zwischen generischem Wissen und spezifischer Anforderung. Anders als beim bloßen Befehlen einer Aufgabe, lieferst du hier den Kontext gleich mit. Die Kernfrage „Was ist ein Few-Shot?“ lässt sich also technisch präzise beantworten: Es ist ein Datensatz aus Input und idealem Output, der dem Modell als temporäre Referenz dient.

Systemisch betrachtet ordnet sich Few Shot Prompting unter dem Begriff des In-Context Learning ein. Das Modell lernt für die Dauer der Session aus den gegebenen Beispielen, ohne dass sich seine internen Parameter ändern. Es ist eine Architektur-Entscheidung für mehr Präzision durch Kontext.

Für eine tiefere Einordnung der Begrifflichkeiten lohnt sich ein Blick in die Grundlagen des Prompt Engineering sowie die Basis-Definition eines Prompts.

Wie funktioniert Few Shot Prompting?

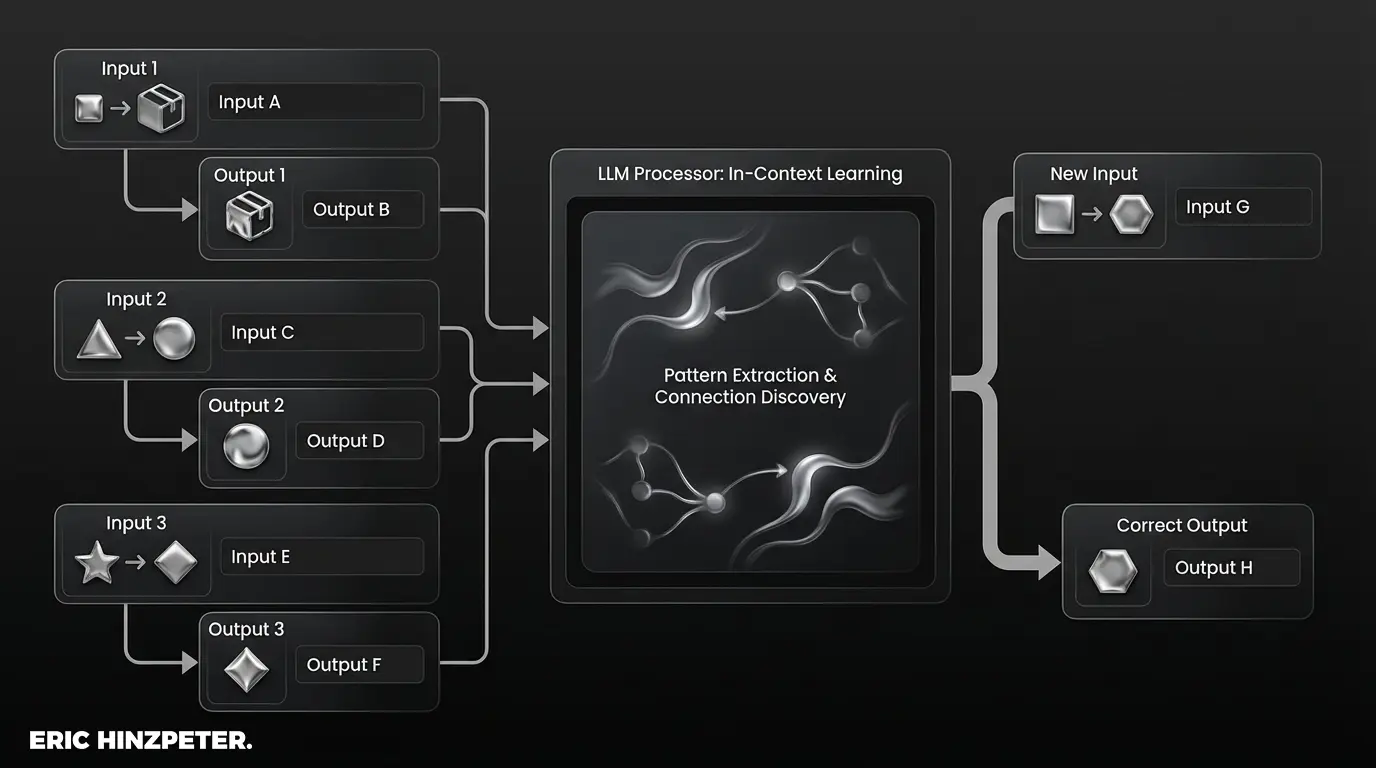

Die Funktionsweise basiert auf der fundamentalen Eigenschaft von Sprachmodellen: der Mustererkennung. Large Language Models (LLMs) wie GPT-4 sind darauf trainiert, Wahrscheinlichkeiten für das nächste Wort in einer Sequenz vorherzusagen. Wenn ein Prompt eine Reihe von Beispielen enthält (z.B. „Frage: A, Antwort: B“), erkennt das Modell die logische Struktur zwischen Input und Output.

Dieses Phänomen wird als In-Context Learning bezeichnet. Das Modell analysiert die semantischen und syntaktischen Beziehungen in den bereitgestellten Beispielen und wendet dieses erkannte Muster auf die eigentliche, neue Aufgabe an. Es findet keine Anpassung der Modellgewichte statt (kein Training im klassischen Sinne), sondern eine temporäre Justierung des Aufmerksamkeitsfokus auf das demonstrierte Schema.

Besonders größere Sprachmodelle profitieren von dieser Methodik, da ihre Kapazität zur Mustererkennung über längere Textsequenzen hinweg stärker ausgeprägt ist. Je klarer das Muster im In-Context Learning definiert ist, desto präziser folgt das Large Language Model der Vorgabe.

Ein tieferes Verständnis der technischen Limitierungen, wie etwa der Verarbeitungskapazität, bietet der Artikel zu Token und LLMs.

Unterschiede: Zero-Shot, One-Shot und Few-Shot

Die Architektur des Prompts entscheidet über die Qualität der Antwort. Man unterscheidet hierbei drei wesentliche Stufen der Kontext-Gabe:

- Zero-Shot Prompting: Dem Modell wird lediglich die Aufgabe gestellt, ohne jegliches Beispiel. Hier muss sich das System rein auf sein pre-trainiertes Wissen verlassen.

Beispiel: „Klassifiziere diesen Text.“ - One-Shot Prompting: Das Modell erhält exakt ein Beispiel. Dies reicht oft aus, um ein Format festzulegen.

Beispiel: „Klassifiziere wie folgt: ‚Toller Service‘ -> Positiv. Klassifiziere nun: ‚Lange Wartezeit‘.“ - Few-Shot Prompting: Dem Modell werden mehrere Beispiele (meist 2 bis 5) präsentiert. Dies ist notwendig, wenn Nuancen unterschieden oder komplexe Formate eingehalten werden müssen.

Der Unterschied zwischen Zero und Few Shot liegt in der Führung. Während Zero-Shot Prompting auf die allgemeine Intelligenz des Modells setzt, zwingt Few-Shot das Modell in ein spezifisches Korsett aus Logik und Format. Wer tiefer in die methodische Abgrenzung einsteigen möchte, findet im Artikel zu Zero-Shot Prompting weitere Details.

Pro-Tipp: Skalierung der Beispiele

Beginne immer mit Zero-Shot, um die Baseline zu testen. Wenn das Ergebnis zu generisch ist, füge nicht sofort fünf Beispiele hinzu. Starte mit einem (One-Shot), um das Format zu fixieren. Erst wenn inhaltliche Nuancen fehlen, ist Few-Shot mit 3-5 Beispielen der architektonisch sauberste Weg.

Vorteile von Few Shot Prompting bei LLMs

Wer die Vorteile von Few Shot Prompting bei LLMs analysiert, erkennt schnell die Auswirkung auf messbare KPIs. Der größte Hebel ist die Output-Qualität. Durch die Vorgabe von Beispielen sinkt die Wahrscheinlichkeit von Halluzinationen, da das Modell in einem definierten Lösungsraum agiert.

Ein weiterer Aspekt ist die Formattreue. Besonders bei der Generierung strukturierter Daten (JSON, CSV, Listen) garantiert Few-Shot, dass Syntax und Schema eingehalten werden. Dies steigert die Effizienz in automatisierten Workflows enorm, da weniger Post-Processing nötig ist.

Zudem ermöglicht diese Methode, auch ohne aufwendiges Nachtraining (Fine-Tuning) komplexe Aufgaben zu lösen. Leistungsstarke Modelle wie GPT-4 zeigen hier eine Modellleistung, die früher spezialisierten Algorithmen vorbehalten war. Die Flexibilität ist hoch: Ändert sich die Anforderung, müssen lediglich die Beispiele im Prompt ausgetauscht werden, nicht das gesamte System.

Praktische Beispiele für Few Shot Prompts

Theorie bildet das Fundament, doch die Logik der Anwendung entscheidet über den Erfolg. Folgende Praktische Beispiele für Few Shot Prompts illustrieren, wie Anwendungsfälle strukturiert werden sollten. Achte bei diesen Beispielen auf die klare Trennung von Input und Output.

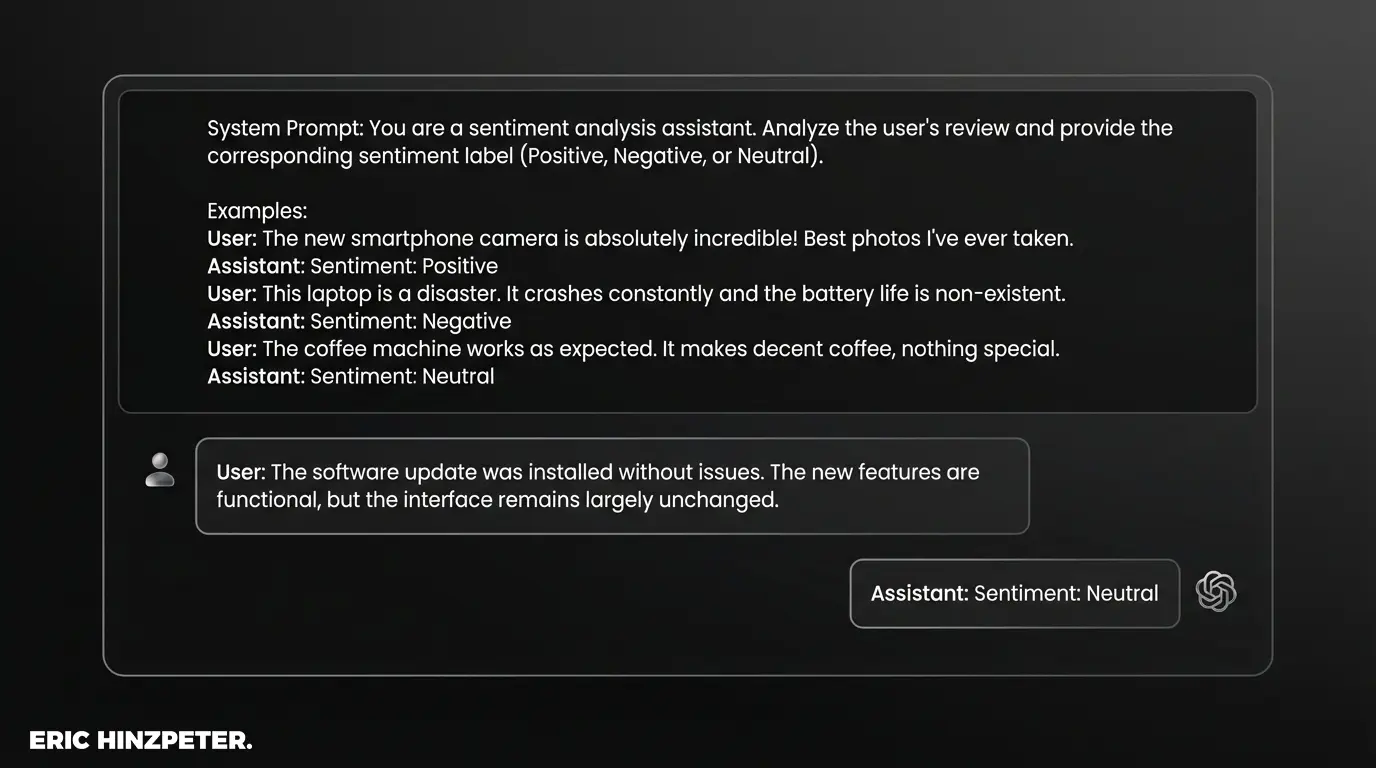

Anwendungsfall 1: Sentiment Analyse

Hier soll das Modell lernen, nicht nur positiv/negativ zu unterscheiden, sondern auch Nuancen wie „Neutral“ oder „Gemischt“ zu erkennen.

Aufgabe: Klassifiziere die Kundenbewertungen in Positiv, Negativ oder Neutral. Review: "Der Versand war schnell, aber das Produkt ist beschädigt." Sentiment: Negativ Review: "Ganz okay für den Preis, erfüllt seinen Zweck." Sentiment: Neutral Review: "Besser als erwartet! Werde ich wieder kaufen." Sentiment: Positiv Review: "Der Support hat mir sofort geholfen, danke." Sentiment: [KI generiert hier: Positiv]

Anwendungsfall 2: Strukturierte Textgenerierung

Für die Textgenerierung im Marketing ist Konsistenz entscheidend. Hier zwingen wir das Modell in ein Format für Produktbeschreibungen.

Wandel die Produkt-Features in einen kurzen Benefit-Satz um. Features: Leichte Bauweise, 12h Akku, Wasserdicht. Benefit: Genieße Musik den ganzen Tag, egal wo du bist – dank ultraleichtem Design und wasserfestem Gehäuse. Features: 4k Auflösung, HDR, Smart-TV Funktionen. Benefit: Erlebe Kinoqualität in deinem Wohnzimmer mit gestochen scharfen Bildern und direktem Zugang zu deinen Lieblings-Apps. Features: Ergonomischer Griff, rostfreier Stahl, Spülmaschinenfest. Benefit: [KI generiert hier den passenden Satz]

Diese Beispiele zeigen dem Modell nicht nur den Inhalt, sondern auch Tonalität und Satzlänge.

Wer tiefer in die Basis-Strukturen einsteigen möchte, findet im Artikel zu Prompting Grundlagen weitere Ansätze.

Best Practices für besseres In-Context Learning

Damit sich Best Practices für besseres In-Context Learning in der Praxis bewähren, muss das Prompt-Design methodisch sauber sein. Ein häufiger Fehler ist die willkürliche Wahl der Beispiele.

- Vielfalt der Beispiele: Die „Shots“ müssen repräsentativ für den gesamten Aufgabenbereich sein. Wenn alle Beispiele kurz sind, wird auch der Output kurz sein. Eine Balance der Klassen (z.B. gleich viele positive wie negative Beispiele) verhindert Bias.

- Konsistente Formatierung: Nutze klare Trennzeichen (z.B. `###` oder `—`) zwischen den Beispielen. Inkonsistenzen im Prompt-Design verwirren das Modell.

- Chain-of-Thought Integration: Bei komplexen logischen Aufgaben lohnt es sich, Chain-of-Thought anzuwenden. Hierbei enthält das Beispiel nicht nur die Antwort, sondern auch den Lösungsweg („Schritt 1: Analyse… Schritt 2: Fazit…“).

Für fortgeschrittene Techniken und aktuelle Forschungsstände lohnt sich oft ein Blick auf Ressourcen wie PromptingGuide.ai.

Few Shot Prompting vs. Fine-Tuning

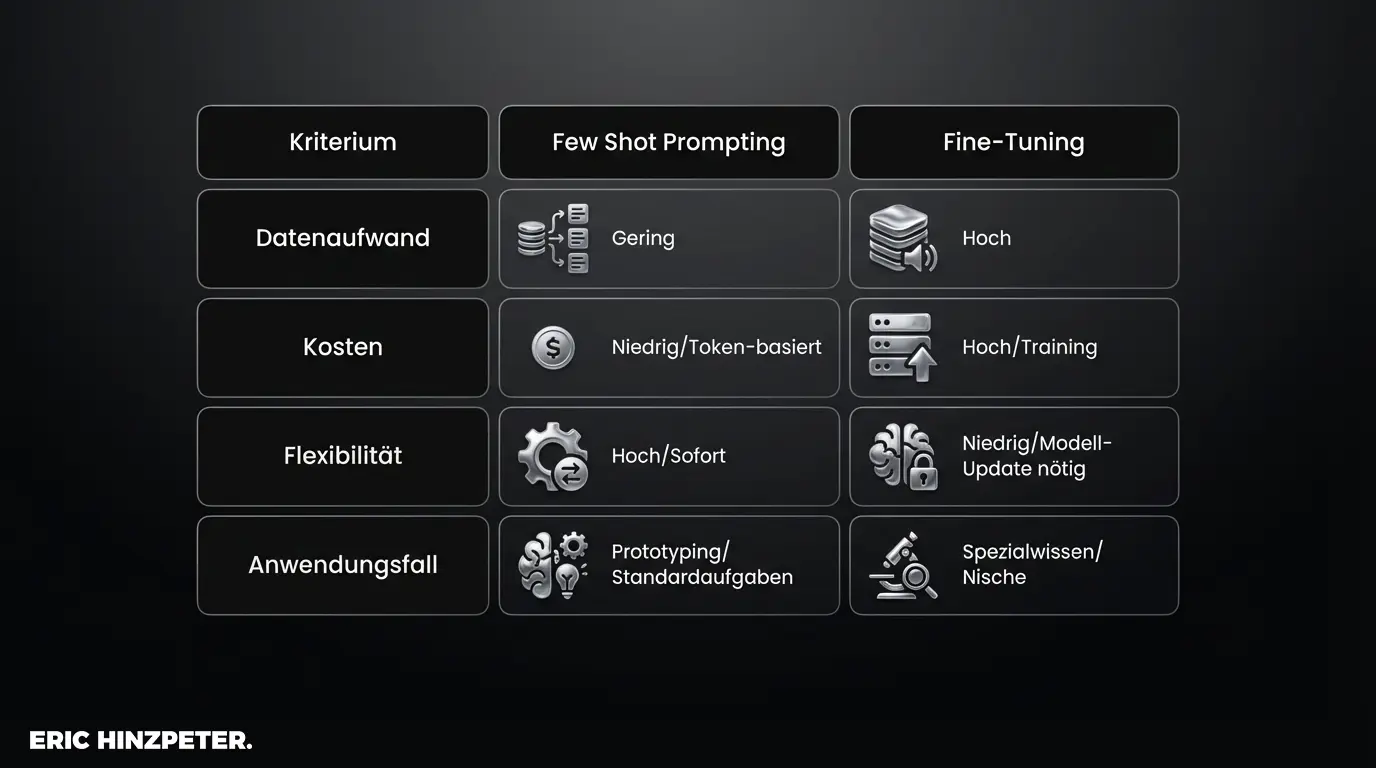

Oft stellt sich die Frage nach der Skalierbarkeit. Wann reicht der Prompt, und wann muss die Maschine trainiert werden? Der Vergleich Few Shot Prompting vs. Fine-Tuning ist im Grunde eine Abwägung von Flexibilität gegen Spezialisierung.

Few Shot Prompting ist agil. Es benötigt keine Anpassung der Modellgewichte, keine Hardware-Ressourcen für das Training und lässt sich in Sekunden iterieren. Es ist ideal, wenn die Aufgabe mit 5-10 Beispielen klar definiert ist.

Fine-Tuning hingegen verändert das Modell dauerhaft. Es benötigt kuratierte Trainingsdaten (oft Tausende) und Rechenleistung. Es ist dann sinnvoll, wenn das Modell tiefes, branchenspezifisches Fachwissen benötigt, das nicht in den Kontext eines Prompts passt, oder wenn ein sehr spezifischer Sprachstil über Millionen von Interaktionen hinweg extrem kosteneffizient (weniger Input-Token) repliziert werden muss.

Häufige Fehler und Herausforderungen

Auch die beste Architektur hat Schwachstellen. Zu den Häufige Fehler und Herausforderungen zählt der sogenannte „Label Bias“. Wenn die Beispiele im Prompt überwiegend eine bestimmte Antwortkategorie (z.B. „Positiv“) zeigen, tendiert das Modell dazu, diese Kategorie auch bei neutralem Input zu wählen. Die Verteilung im Prompt beeinflusst die Verteilung im Output massiv.

Ein technischer Engpass ist das Token-Limit. Jedes Beispiel verbraucht wertvollen Platz im Kontext-Fenster des Modells. Bei sehr langen Beispielen kann es passieren, dass für die eigentliche Aufgabe oder die Antwort der Platz ausgeht. Hier gilt: Qualität vor Quantität. Mehr dazu im Glossar-Eintrag zu Token-Limits.

Pro-Tipp: Recency Bias vermeiden

Sprachmodelle gewichten Informationen, die am Ende des Prompts stehen, oft stärker. Wenn deine Beispiele eine bestimmte Reihenfolge haben, mische sie durch oder platziere das wichtigste Format-Beispiel möglichst nah an der finalen Aufgabenstellung.

Fazit & Ausblick

Few Shot Prompting transformiert die Arbeit mit Künstlicher Intelligenz von einem Glücksspiel in einen kontrollierbaren Prozess. Es ist die effizienteste Methode, um ohne technisches Training die Denkweise eines LLMs zu lenken. Während Zero-Shot Prompting für generische Aufgaben ausreicht, ist Few-Shot der Standard für professionelle Anwendungen.

Der Ausblick ist klar: Mit wachsenden Kontext-Fenstern (Modelle, die ganze Bücher als Input verarbeiten können) entwickelt sich die Technik hin zum „Many-Shot Prompting“. Doch das Prinzip bleibt bestehen: Die Qualität des Outputs korreliert direkt mit der Qualität der im Kontext bereitgestellten Muster.