Oft wird Machine Learning (ML) synonym mit Künstlicher Intelligenz verwendet. Eine ungenaue Gleichsetzung, die den Blick auf das Wesentliche verstellt: Die Architektur der Datenverarbeitung. Die Frage ist nicht, was die Technologie könnte, sondern welche Logik sie im Kern antreibt. Wer verstehen will, wie moderne Systeme Vorhersagen treffen, muss die Mechanismen im Maschinenraum kennen.

Hier geht es weniger um futuristische Visionen, sondern um die mathematische und strukturelle Realität, die den heutigen Tech-Stack definiert.

Was ist maschinelles Lernen?

Maschinelles Lernen ist ein Teilgebiet der Informatik und das operative Herzstück der Data Science. Während bei der klassischen Programmierung Menschen explizite Regeln (Wenn-Dann-Logiken) definieren, um einen Output zu erzeugen, dreht ML diesen Prozess um.

Systeme werden befähigt, Muster in Daten zu erkennen und eigenständig Lösungswege zu entwickeln. Der Computer wird nicht programmiert, wie er eine Aufgabe lösen soll, sondern er wird trainiert, die Lösung anhand von Beispielen selbst zu finden.

Ein Vergleich zur Verdeutlichung des Prinzips: Stell dir vor, du bringst einem Kind bei, den Unterschied zwischen einem Hund und einer Katze zu erkennen. Du gibst ihm keine Liste mit Regeln wie „Hunde haben Schlappohren“. Stattdessen zeigst du dem Kind tausende Bilder und benennst sie: „Das ist ein Hund“, „Das ist eine Katze“. Mit der Zeit lernt das Gehirn, die visuellen Merkmale selbstständig zu abstrahieren. Genau so funktioniert Machine Learning – nur mit mathematischen Funktionen statt Neuronen.

Insight: Buzzwords vs. Realität

Wenn Anbieter von „KI-Lösungen“ sprechen, lohnt sich ein Blick unter die Haube. Handelt es sich um echtes Machine Learning mit Feedback-Schleife oder nur um statische Wenn-Dann-Regeln? Die Differenzierung entscheidet über die Skalierbarkeit deiner Architektur.

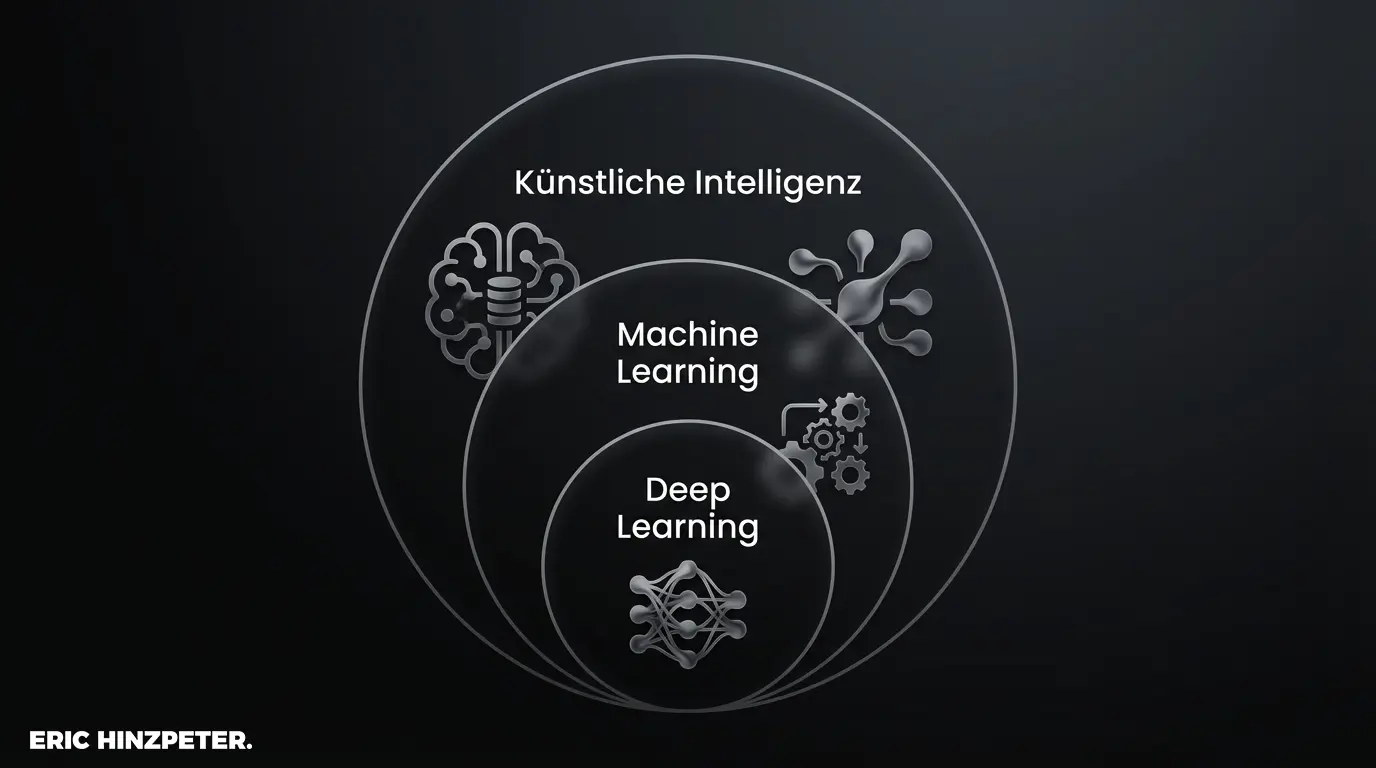

Unterschied zwischen KI, Machine Learning und Deep Learning

Die Begriffe werden oft vermischt, aber die Hierarchie ist entscheidend für das Verständnis der Systematik:

- Künstliche Intelligenz (KI): Der übergeordnete Begriff für jede Maschine, die intelligentes Verhalten imitiert.

- Machine Learning (ML): Ein Teilbereich der KI. Hier lernen Algorithmen aus Daten, um Vorhersagen zu treffen.

- Deep Learning (DL): Eine spezialisierte Form des ML, die auf künstlichen neuronalen Netzen basiert. Sie ist inspiriert von der Funktionsweise des menschlichen Gehirns und ermöglicht die Verarbeitung riesiger Datenmengen (z.B. bei Generative AI).

Ein Blick auf diese Struktur zeigt: Nicht jede KI nutzt Machine Learning, aber fast jede moderne, leistungsfähige KI basiert darauf.

Wie funktioniert maschinelles Lernen?

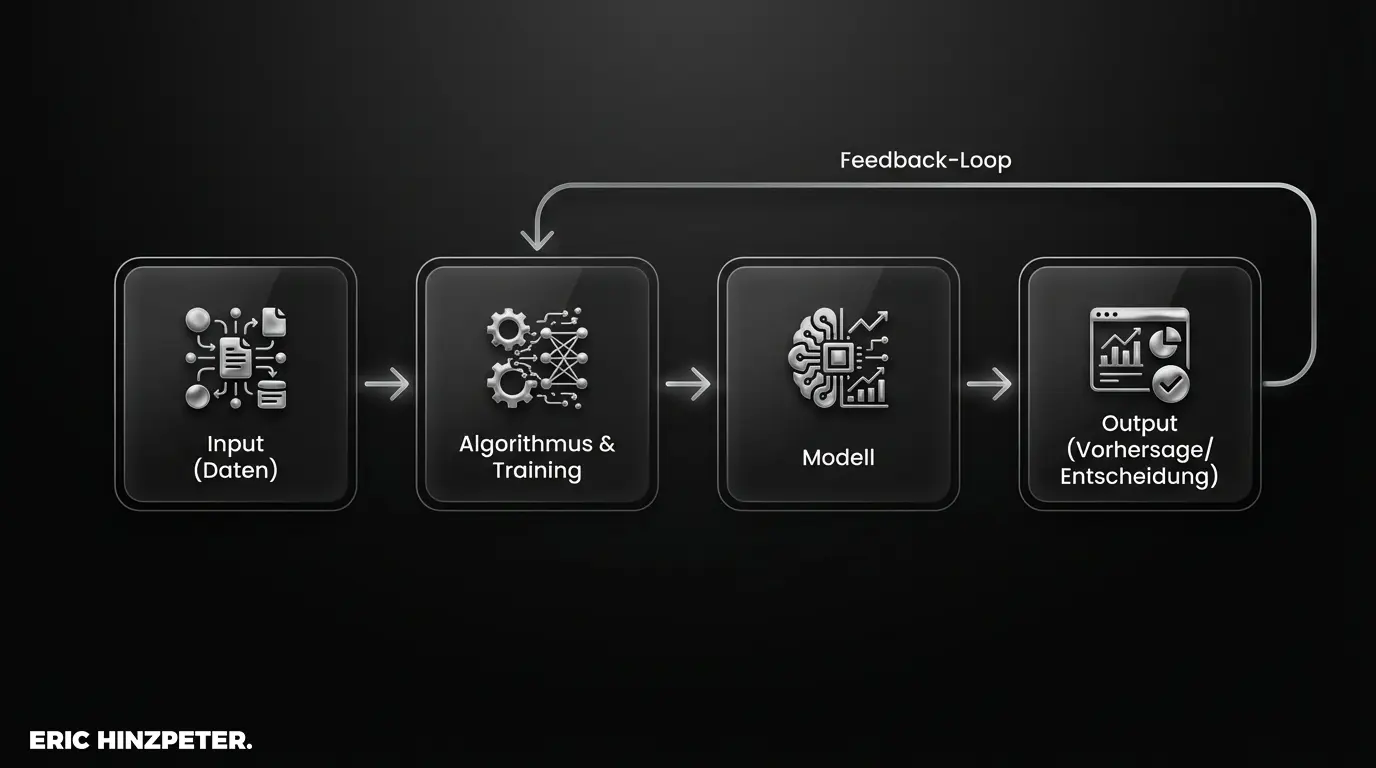

Der Kernprozess ist die Transformation von Rohdaten in Erkenntnisse. Dies geschieht durch Mustererkennung. Anstatt dass ein Programmierer den Code schreibt, „schreibt“ der Algorithmus sein eigenes internes Modell, indem er Korrelationen in den Daten findet.

Die Rolle von Algorithmen und Trainingsdaten

Wenn man ML mit Kochen vergleicht, sind Algorithmen das Werkzeug (z.B. der Ofen) und die Trainingsdaten die Zutaten. Das Ergebnis hängt maßgeblich von der Qualität der Zutaten ab.

In der Praxis gilt das Prinzip „Garbage In, Garbage Out“. Egal wie effizient der Algorithmus ist – wenn die Daten unvollständig, voreingenommen (Bias) oder fehlerhaft sind, liefert das Modell falsche Ergebnisse. Daten können dabei strukturiert (Tabellen) oder unstrukturiert (Bilder, Texte) vorliegen.

Vom Modelltraining zur Vorhersage

Der Lebenszyklus eines ML-Modells folgt einer klaren Logik:

- Modelltraining: Der Algorithmus analysiert historische Daten, um Regeln abzuleiten. Ein Teil der Daten (Testdaten) dient zur Validierung des Lernerfolgs.

- Inferenz (Vorhersage): Das trainierte Modell wird auf neue, unbekannte Daten angewendet, um Entscheidungen zu treffen oder Werte vorherzusagen.

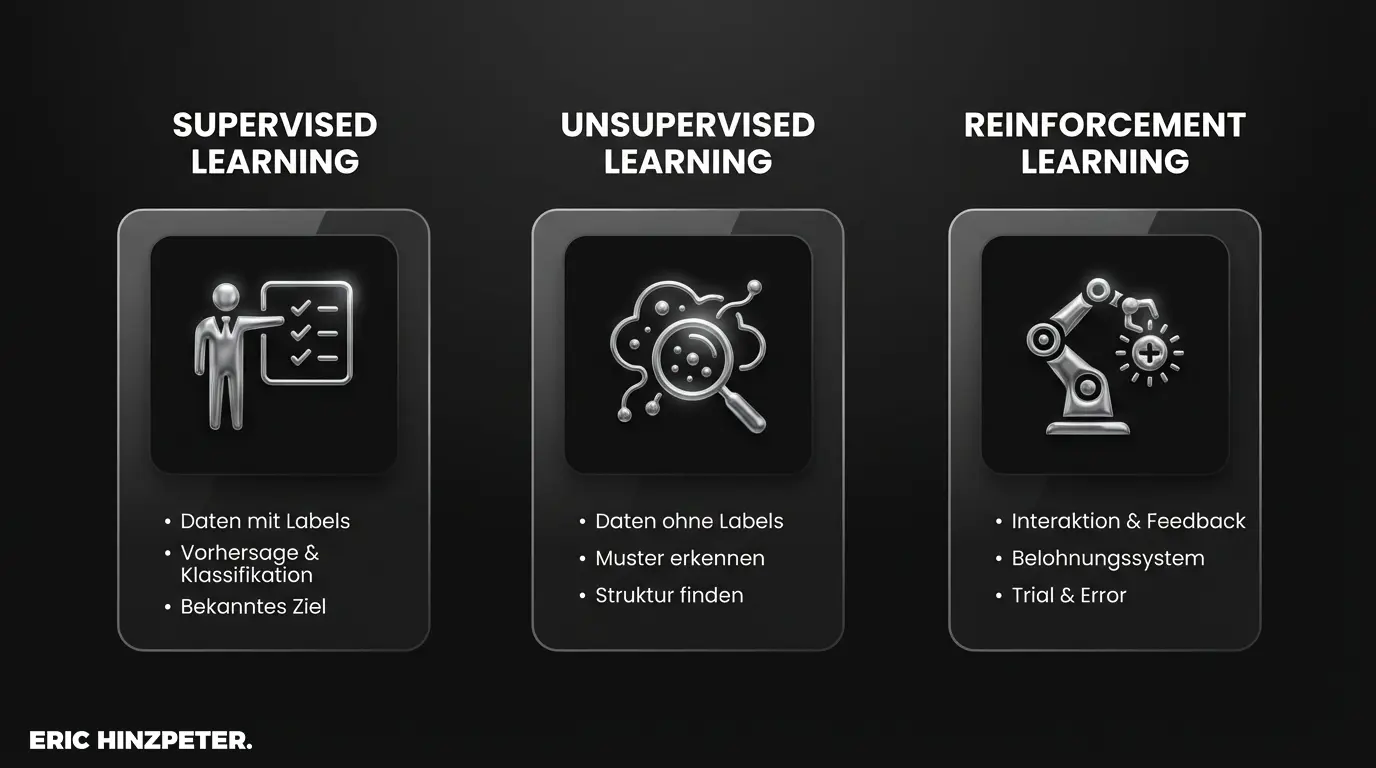

Die verschiedenen Arten von Machine Learning

Nicht jedes Problem wird auf die gleiche Weise gelöst. Je nach Verfügbarkeit der Daten und dem gewünschten Ziel unterscheidet man drei Hauptparadigmen.

Überwachtes Lernen (Supervised Learning)

Beim Überwachten Lernen fungiert der Datensatz als Lehrer. Die Trainingsdaten sind „gelabelt“, das heißt, zu jedem Input (z.B. E-Mail-Text) ist der korrekte Output (z.B. „Spam“ oder „Kein Spam“) bereits bekannt. Das System lernt, den Input auf den Output abzubilden.

Klassische Anwendungsfälle sind Klassifikationen (Bilderkennung) oder Regressionen (Vorhersage von Immobilienpreisen).

Unüberwachtes Lernen (Unsupervised Learning)

Hier gibt es keine Labels und keinen Lehrer. Beim Unüberwachten Lernen wird das System mit Rohdaten gefüttert und muss selbstständig Strukturen finden. Es sucht nach Ähnlichkeiten oder Muster, die für das menschliche Auge oft unsichtbar sind.

Typische Beispiele sind die Kundensegmentierung im Marketing (Clustering) oder die Anomalieerkennung in der IT-Sicherheit.

Bestärkendes Lernen (Reinforcement Learning)

Das Bestärkende Lernen basiert auf dem Prinzip von Versuch und Irrtum. Ein Agent interagiert mit einer Umgebung und erhält für jede Aktion eine Belohnung oder Bestrafung. Ziel ist es, die langfristige Belohnung zu maximieren.

Diese Methodik ist die Basis für komplexe Systeme wie autonomes Fahren und moderne Agentic AI.

Beliebte Tools und Programmiersprachen

Die Architektur hinter ML ist heute standardisiert. Wer tief in die Materie einsteigt oder Teams steuert, sollte den Tech-Stack kennen.

Python als Standard in der Datenanalyse

Python hat sich als absolute Lingua Franca im Bereich ML und Datenanalyse durchgesetzt. Die Gründe sind pragmatisch: Die Syntax ist klar, und die Community hat leistungsfähige Bibliotheken entwickelt, die komplexe Mathematik in einfache Befehle verpacken.

Frameworks: TensorFlow und Scikit-learn

Niemand programmiert neuronale Netze heute mehr von Hand. Data Scientists nutzen Frameworks:

- Scikit-learn: Die Standardbibliothek für klassische Algorithmen (Regression, Clustering). Dokumentation und Beispiele finden sich direkt bei scikit-learn.org.

- TensorFlow (Google) & PyTorch (Meta): Die Schwergewichte für Deep Learning und komplexe neuronale Netze.

Für einen tieferen Einblick in die Software-Landschaft lohnt sich ein Blick auf den AI Tool Stack.

Wichtige Anwendungsgebiete in der Praxis

Theorie ist gut, aber der Transfer in die Wertschöpfung entscheidet über den Erfolg. ML ist längst keine reine Forschung mehr, sondern Business-Alltag.

Automatisierung und Predictive Analytics

Durch die Verbindung von Automatisierung und ML entstehen intelligente Prozessketten. Predictive Analytics ermöglicht es beispielsweise in der Industrie, den Ausfall von Maschinen vorherzusagen (Predictive Maintenance), bevor er passiert. Im Vertrieb können Absatzprognosen präzisiert werden, was Lagerhaltungskosten massiv senkt.

Insight: Prozess-Check

Bevor du ML einführst, prüfe deine Prozesse auf Wiederholbarkeit und Datenverfügbarkeit. ML lohnt sich dort am meisten, wo hohe Volumina an Entscheidungen getroffen werden müssen, die für Menschen zu zeitaufwendig, aber logisch ableitbar sind. Mehr dazu findest du unter AI Automation.

Natural Language Processing und Computer Vision

Zwei Felder dominieren die aktuelle Wahrnehmung:

- Natural Language Processing (NLP): Die Fähigkeit von Maschinen, Sprache zu verstehen und zu generieren. Dies ist die Schnittstelle, an der auch Prompt Engineering ansetzt.

- Computer Vision: Von der Qualitätskontrolle in der Produktion bis zur Analyse von Röntgenbildern in der Medizin – hier lernen Maschinen das „Sehen“.

Vorteile und Herausforderungen von Machine Learning

Die Systematik von ML bringt immense Vorteile, aber auch strukturelle Risiken mit sich.

Vorteile:

- Effizienzsteigerung durch Automatisierung komplexer Aufgaben.

- Erkennung von Zusammenhängen in Big Data, die Menschen übersehen würden.

- Je mehr Daten, desto besser das Modell.

Herausforderungen:

- Datenqualität: Fehlerhafte Daten führen zu fehlerhaften Modellen.

- Bias: Wenn Trainingsdaten Vorurteile enthalten, wird das Modell diese diskriminierenden Muster reproduzieren.

- Black Box: Bei komplexen neuronalen Netzen ist oft nicht nachvollziehbar, warum eine Entscheidung getroffen wurde.

Zukunftstrends im Bereich maschinelles Lernen

Die Entwicklung beschleunigt sich. Aktuell sehen wir eine massive Demokratisierung durch AutoML (Automated Machine Learning), wodurch auch Nicht-Experten Modelle trainieren können. Der wichtigste Trend bleibt jedoch der Shift zu Generative AI – Systemen, die nicht mehr nur analysieren, sondern Neues erschaffen.

Insight: Strategische Integration

Starte nicht mit dem komplexesten Problem. Suche einen „Low Hanging Fruit“-Use Case, um Erfahrungen mit der Datenpipeline zu sammeln. Die Architektur ist wichtiger als das einzelne Tool. Wer hier sauber aufbaut, ist bereit für kommende Standards.