Was ist Context Engineering und warum ist es wichtig?

Context Engineering ist die logische Evolution, wenn einfache Prompts an ihre Grenzen stoßen. Es bezeichnet die systematische Konstruktion, Optimierung und Verwaltung des Informationsumfelds (Kontext), das einem Large Language Model (LLM) zur Verfügung gestellt wird. Anders als beim reinen Prompting, das sich auf die direkte Anweisung konzentriert, geht es hier um das Design der „Umgebung“, in der die KI agiert.

In der technischen Praxis nutzen wir Context Engineering, um die Wissenslücken generativer KI zu schließen. Ein Standard-Modell weiß nur das, was in seinen Trainingsdaten enthalten war – und das ist oft veraltet. Durch gezieltes Environment Design – oft als In-Context Learning bezeichnet – injizieren wir dynamisch relevantes Wissen in den Prozess, bevor das Modell überhaupt eine Antwort generiert.

Systemisch betrachtet ist dies der Wechsel von einer reinen Chat-Interaktion hin zu einer stabilen Architektur. Wer KI im Unternehmen skalieren will, muss weg von „kreativen Prompts“ und hin zu robusten Daten-Pipelines. Technisch validiert wird dieses Vorgehen auch durch Dokumentationen führender Labore, wie etwa in den Best Practices von Anthropic zum Thema Context Window.

Der Unterschied zwischen Prompt Engineering und Context Engineering

Vielerorts herrscht noch immer Verwirrung zwischen diesen beiden Disziplinen. Dabei ist die Trennung logisch und architektonisch notwendig. Machen wir es kurz:

- Prompt Engineering befasst sich mit der Instruktion: „Wie frage ich die KI, um das beste Ergebnis zu erhalten?“ Es ist die Optimierung der Anweisung (Instruction). Mehr dazu findest du im Glossar-Eintrag zu Prompt Engineering.

- Context Engineering befasst sich mit der Informationsbasis: „Was weiß die KI zum Zeitpunkt der Frage?“ Es ist die Optimierung der verfügbaren Daten (Grounding).

Eine einfache Analogie verdeutlicht dies: Das Prompting ist das Rezept, das du einem Koch gibst. Context Engineering ist das Befüllen der Speisekammer. Selbst mit dem besten Rezept (Prompt) wird der Koch scheitern, wenn die Speisekammer leer ist oder nur falsche Zutaten enthält.

Wie Context Engineering die Genauigkeit von LLMs verbessert

Das Hauptproblem isolierter Sprachmodelle ist ihre Tendenz zu Halluzinationen. Wenn ein Modell die Antwort nicht kennt, erfindet es oft eine plausibel klingende Unwahrheit. Context Engineering fungiert hier als Leitplanke.

Indem wir den Kontext mit verifizierten Fakten anreichern, zwingen wir das Modell, diese Informationen zu nutzen. Dies ist der effektivste Weg, um Halluzinationen zu reduzieren. Der LLM-Output basiert dann nicht mehr auf den probabilistischen Wahrscheinlichkeiten der Trainingsdaten, sondern auf den konkret bereitgestellten Fakten im Kontextfenster (Grounding). Ein LLM ohne Kontext ist ein fantastischer Lügner; mit Kontext wird es zum Analysten.

Kontextuelle Relevanz und Datenqualität als Schlüsselfaktoren

Es reicht nicht, einfach wahllos Daten in das Modell zu kippen. Die Architektur entscheidet über den Erfolg. Zwei Faktoren sind hierbei kritisch:

- Kontextuelle Relevanz: Das Kontextfenster eines LLMs ist begrenzt (und teuer). Wir müssen sicherstellen, dass nur Informationen mit hoher Relevanz eingespeist werden (High Signal-to-Noise Ratio). Irrelevante Daten verwirren das Modell eher, als dass sie helfen.

- Datenqualität: Das Prinzip „Garbage in, Garbage out“ gilt hier absolut. Wenn die Quelldaten unstrukturiert oder fehlerhaft sind, wird auch die beste KI-Architektur keine sauberen Ergebnisse liefern.

Pro-Tipp: Grounding

Verlass dich nie darauf, dass das Modell „schon wissen wird“, was wichtig ist. Definiere im System, dass Antworten ausschließlich auf dem bereitgestellten Kontext basieren dürfen. Wenn die Information im Kontext fehlt, muss das Modell antworten: „Ich weiß es nicht“, statt zu raten.

Technische Grundlagen: Die Bedeutung von RAG und Vektordatenbanken

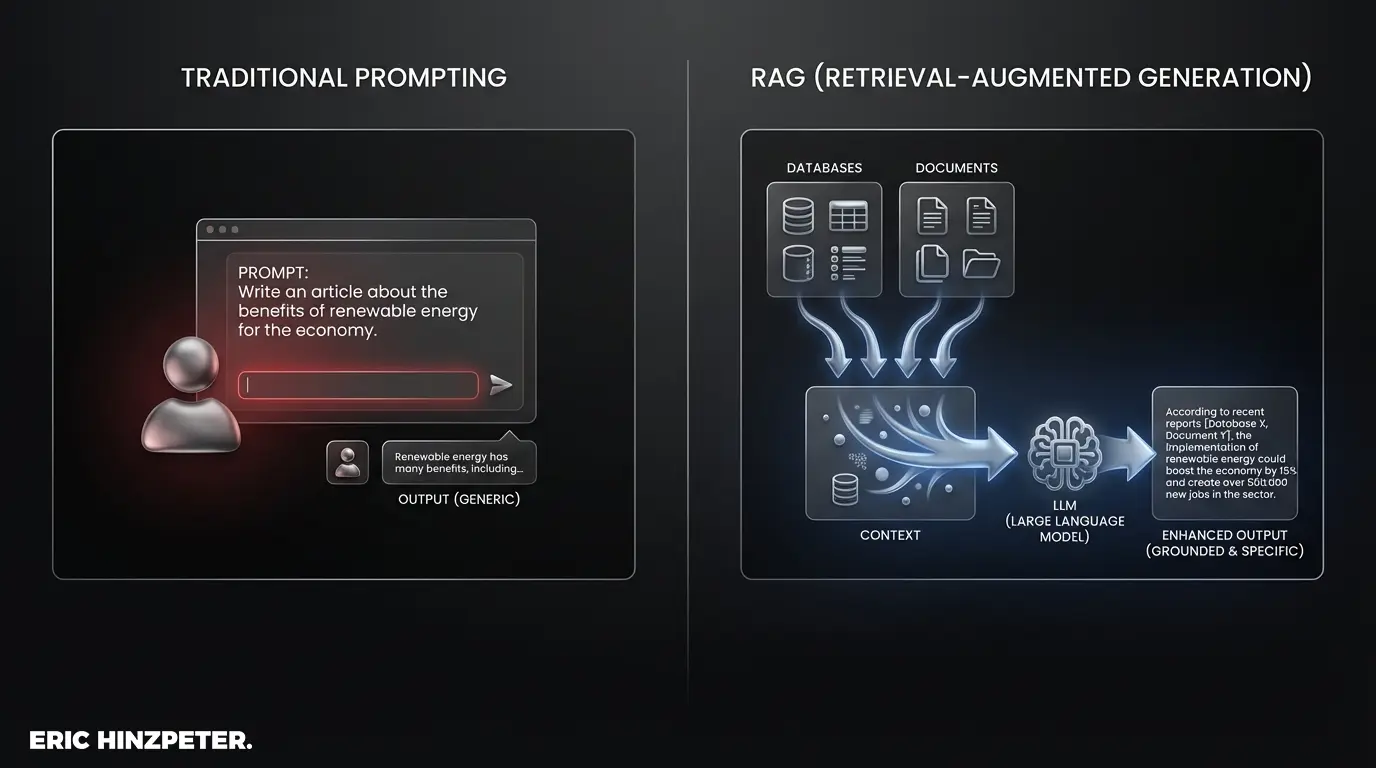

Kommen wir zur technischen Logik. Context Engineering wird in modernen Anwendungen fast immer über eine RAG-Architektur (Retrieval Augmented Generation) realisiert. Dies ist der Industriestandard, um externe Daten mit generativer KI zu verbinden. Wer heute noch statische Prompts ohne RAG für komplexe Aufgaben nutzt, verbrennt Budget.

Dabei dient eine Vektordatenbank als externes Langzeitgedächtnis. Anders als klassische Datenbanken speichern diese Systeme Informationen als mathematische Vektoren (Embeddings). Dies ermöglicht es, Zusammenhänge und Bedeutungen zu speichern, statt nur nach exakten Wortlauten zu suchen.

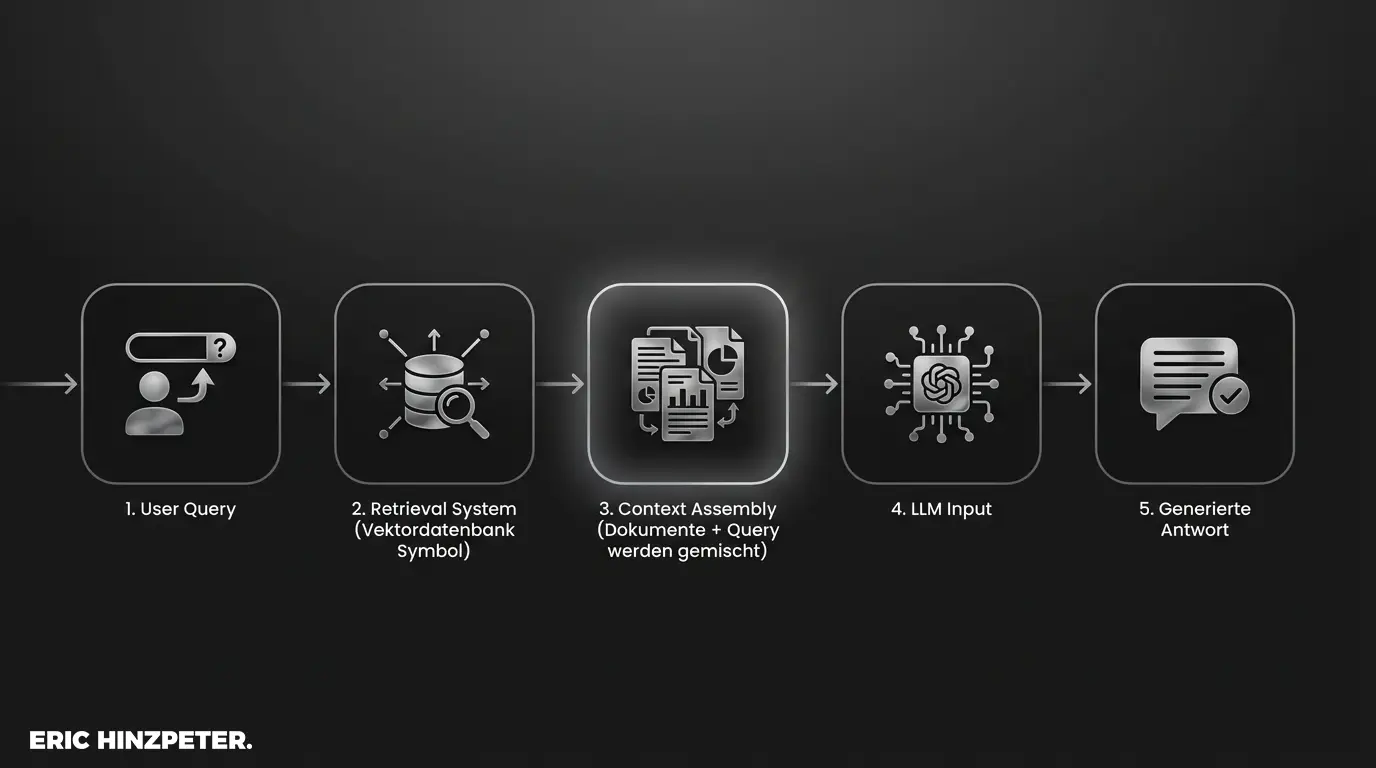

Der Prozess der Datenintegration läuft dabei meist wie folgt ab:

- Der Nutzer stellt eine Frage.

- Das System durchsucht die Wissensdatenbank (Vektordatenbank) nach den relevantesten Informationsschnipseln.

- Diese Schnipsel werden in den Kontext des Prompts integriert.

- Das LLM generiert die Antwort basierend auf diesem angereicherten Kontext.

Für tiefergehende technische Details zur Funktionsweise von Vektoren empfehle ich die Dokumentationen von Anbietern wie Pinecone oder Weaviate.

Semantische Suche zur Informationsbeschaffung

Das Herzstück des Retrievals ist die Semantische Suche. Sie ermöglicht es dem System, Dokumente zu finden, die thematisch passen, auch wenn sie ganz andere Wörter verwenden als die Suchanfrage des Nutzers. Ohne eine funktionierende semantische Suche scheitert das Context Engineering meist, daran, dass dem Modell die falschen Informationen zugespielt werden.

Strategie-Check

Willst du Context Engineering im Unternehmen implementieren, aber die Architektur bereitet Kopfzerbrechen? Analysiere erst deine Datenstruktur, bevor du Tools kaufst.

Das Kontextfenster: Definition und Grenzen

Technisch gesehen findet Context Engineering innerhalb des sogenannten „Kontextfensters“ (Context Window) statt. Dies ist der Arbeitsspeicher des Modells, gemessen in Tokens. Jedes Wort, jedes Satzzeichen und jede Information verbraucht Platz.

Das Kontextfenster ist eine harte technische Grenze (auch wenn sie sich stetig erweitert). Schlechtes Token-Management führt dazu, dass wichtige Informationen am Anfang oder in der Mitte des Fensters vom Modell „vergessen“ oder ignoriert werden (Lost-in-the-Middle Phänomen). Eine effiziente Kontext-Optimierung ist daher Pflicht, um Kosten und Latenz im Griff zu behalten.

Wichtig: Die Herausforderungen im Umgang mit diesen Grenzen und spezifische Optimierungsstrategien sind komplex und würden den Rahmen dieser Definition sprengen. Ich habe dafür einen separaten Deep-Dive erstellt. Für detaillierte Lösungen und Praxis-Tipps lies bitte meinen Artikel: Context Engineering: Herausforderungen und Tipps.

Falls du die Grundlagen zu Tokens noch nicht kennst, findest du hier die Definition: Was sind Token bei LLMs?

Context Engineering für autonome AI-Agenten

Der Blick in die Zukunft zeigt: Context Engineering wird zur Kernkompetenz für KI-Agenten. Während ein Chatbot nur eine Antwort liefert, führen autonome Agenten ganze Prozessketten aus. Dafür benötigen sie ein Gedächtnis.

Ohne sauberes Context Engineering „vergisst“ ein Agent nach Schritt 3, was er in Schritt 1 getan hat. In einer robusten KI-Systemarchitektur sorgt das Context Management dafür, dass der Agent seinen Status, seine Ziele und vergangene Aktionen konsistent abrufen kann. Nur so ist echte Automatisierung komplexer Workflows möglich.

Mehr zur Funktionsweise autonomer Systeme findest du unter Agentic AI.

Zukunftstrends: Von Prompting zu System-Design

Wir bewegen uns weg vom manuellen Schreiben einzelner Prompts. Die Rolle des „Prompt Engineers“ entwickelt sich weiter zum „AI Systems Engineer“. Ein wesentlicher Bestandteil davon sind System-Prompts – statische Anweisungen, die fest im Kontext verankert sind und das Verhalten der KI global steuern.

Die Architektur gewinnt über die Rhetorik. Wer die Datenflüsse beherrscht, beherrscht die Qualität der KI-Antwort.

Häufig gestellte Fragen (FAQ)

Was ist der Unterschied zwischen Prompt und Context Engineering?

Prompt Engineering optimiert die direkte Anweisung an die KI (Instruction). Context Engineering konstruiert und optimiert die Datenbasis und Umgebung, auf die das Modell zugreift, um diese Anweisung auszuführen (Environment).

Warum ist Context Engineering für KI-Agenten wichtig?

Autonome Agenten benötigen ein dynamisches Kontext-Management, um über längere Zeiträume konsistent zu handeln und relevante Informationen aus einem „Gedächtnis“ abzurufen, statt jeden Schritt isoliert zu betrachten.

Welche Rolle spielen Vektordatenbanken beim Context Engineering?

Sie dienen als externer Langzeitspeicher. Mittels semantischer Suche (RAG) werden relevante Wissensschnipsel aus der Datenbank abgerufen und dynamisch in das Kontextfenster des LLMs injiziert.

Fazit

Context Engineering ist kein Buzzword, sondern das architektonische Fundament für verlässliche KI-Anwendungen im Unternehmensumfeld. Wer KI nicht nur als Spielzeug, sondern als Werkzeug begreift, kommt an der systematischen Aufbereitung des Kontextes nicht vorbei.

Wie bereits erwähnt: Dies war die theoretische Definition der Logik. Die harte Praxis – wie du Token sparst, Chunking-Strategien anwendest und technische Hürden meisterst – findest du im Detail in meinem Blog-Artikel zu den Herausforderungen und Tipps.

Stay Updated

Abonniere meinen Newsletter für wöchentliche Deep-Dives in KI-Architekturen.