Vergessen wir kurz die Marketing-Folien. KI ist Mathematik, keine Magie. Und diese Mathematik ist hungrig. Wer glaubt, er könne ein Modell mit beliebigen Daten füttern und erhalte Gold zurück, hat die Logik der Architektur nicht verstanden. Trainingsdaten sind nicht einfach nur „Content“ – sie sind das fundamentale Lehrmaterial, mit dem Algorithmen gefüttert werden, um Muster zu erkennen. Sie sind der Treibstoff, der aus statischer Statistik eine dynamische Vorhersagemaschine macht.

Definition: Was sind Trainingsdaten für KI?

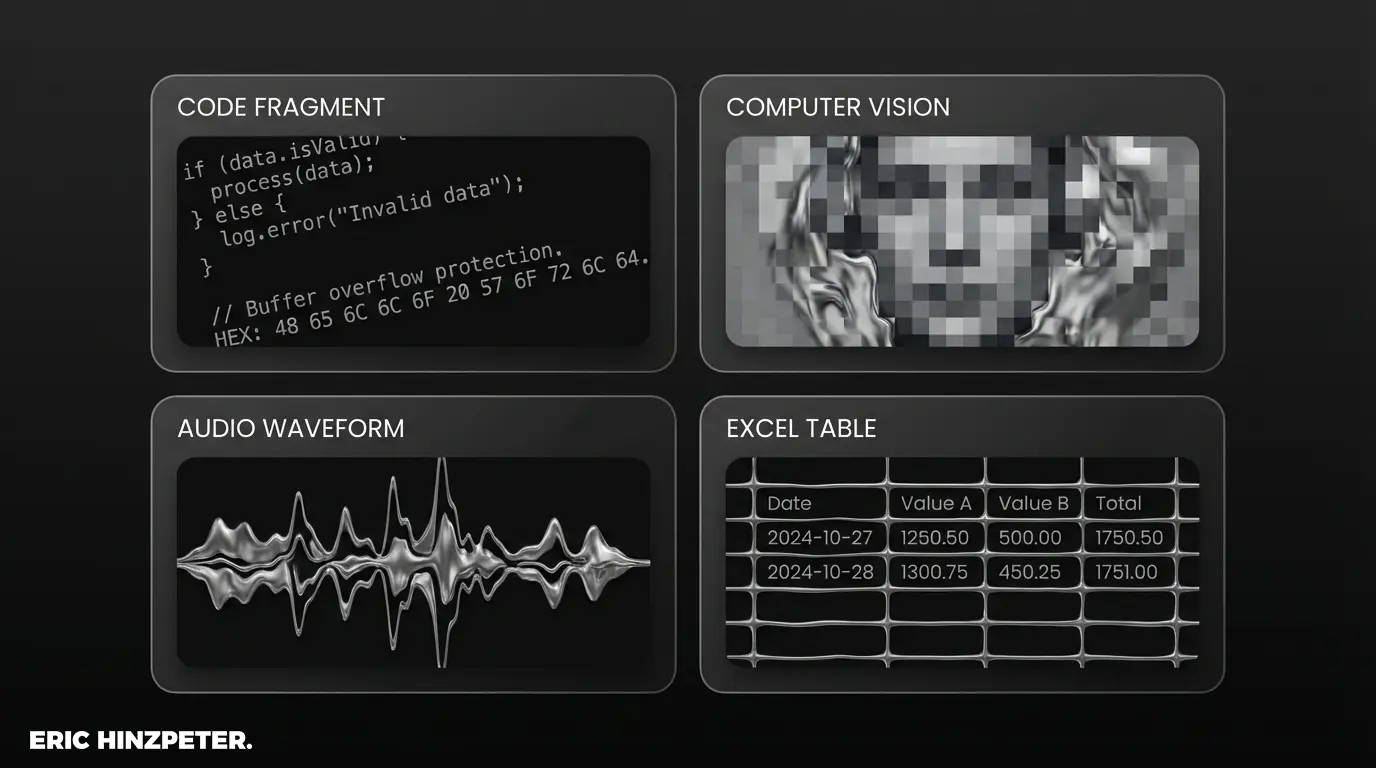

Im klassischen Maschinelles Lernen (ML) war die Welt noch übersichtlich: strukturierte Tabellen rein, Label raus. Aber wenn wir heute über moderne KI oder Large Language Models (LLMs) sprechen, verschiebt sich die Definition. Hier reden wir nicht mehr über Excel-Zeilen, sondern über Tokens. Ein LLM „liest“ keine Texte im menschlichen Sinne. Es analysiert gigantische Korpora – oft große Teile des offenen Internets –, zerlegt diese in statistische Einheiten und berechnet Wahrscheinlichkeiten für das nächste Wort.

Man muss hier technisch sauber unterscheiden: Es gibt die Input-Daten (Features), die das Modell analysiert, und im überwachten Lernen (Supervised Learning) die erwarteten Output-Daten (Labels), die dem System sagen, ob es richtig lag. Die Qualität dieses Materials entscheidet darüber, ob deine KI-Modelle später halluzinieren oder funktionieren. Das ist im Grunde kein Hexenwerk, auch wenn manche Berater das gerne so verkaufen.

Wer tiefer in die Mechanismen eintauchen will, findet im Glossar Artikel zu Maschinelles Lernen oder zur Skalierung dieser Prinzipien hin zur Artificial General Intelligence (AGI).

Warum ist die Qualität von Trainingsdaten entscheidend?

Es gilt das alte Informatik-Gesetz: Garbage in, Garbage out. Das klingt abgedroschen, ist aber bei neuronalen Netzen fataler denn je. Wenn die Trainingsbasis fehlerhaft ist, hilft auch die teuerste Rechenpower nicht. Das Modell lernt den Fehler nicht nur, es generalisiert ihn.

Das größte Risiko liegt hier nicht in technischen Abstürzen, sondern in der Logik der Antworten. Schlechte Datenqualität führt zu zwei massiven Problemen:

- Halluzinationen: Wenn ein LLM mit faktisch falschen Informationen gefüttert wurde, wird es diese Lügen mit absolutem Selbstbewusstsein reproduzieren.

- Bias in KI: Das ist der gefährlichere Teil. Wenn ein Datensatz für Bewerbungsverfahren vorwiegend Lebensläufe weißer Männer aus den letzten 20 Jahren enthält, wird die KI statistisch schlussfolgern, dass dieses Profil „erfolgreicher“ ist. Der Algorithmus ist nicht rassistisch, er ist nur ein Spiegel schlechter Daten-Selektion.

Herausforderungen beim Data Labeling und der Annotation

Viele stellen sich KI-Training als vollautomatischen Prozess vor. Die Realität sieht oft anders aus: In riesigen Klick-Fabriken sitzen Menschen und ziehen Boxen um Autos auf Bildern oder markieren Sarkasmus in Texten. Das ist Data Labeling (oder Datenannotation). Damit ein Modell „versteht“, was eine Katze ist, muss ihm vorher tausendmal jemand gezeigt haben: „Hier, Katze.“

Das Problem an dieser „Human-in-the-Loop“-Architektur ist die Skalierbarkeit. Menschen machen Fehler, werden müde und interpretieren Dinge unterschiedlich. Inkonsistente Labels sind Gift für den Lernprozess (Loss Function), da das Modell widersprüchliche Signale erhält.

Pro-Tipp: Labeling-Qualität sichern

Verlassen Sie sich bei kritischen Projekten nie auf simples Crowdsourcing ohne Qualitätskontrolle. Nutzen Sie „Consensus Labeling“: Lassen Sie denselben Datensatz von drei verschiedenen Personen labeln. Nur wenn Übereinstimmung herrscht, gilt das Datum als validiert. Das kostet mehr, spart aber Monate an Debugging.

Welche Arten von Trainingsdaten gibt es?

Die Architektur bestimmt das Format. Während klassische Statistik-Modelle Tabellen lieben, hungert Deep Learning nach unstrukturiertem Chaos, um darin Muster zu finden. Wir unterscheiden im Wesentlichen zwei Kategorien:

- Strukturierte Daten: Alles, was in eine SQL-Datenbank passt. Kundenstammdaten, Sensorwerte, Finanztransaktionen. Hier ist die Vorbereitung einfach, aber der Informationsgehalt oft begrenzt auf das, was wir bereits gemessen haben.

- Unstrukturierte Daten: Hier passiert die aktuelle Magie. Texte für Natural Language Processing (NLP), Bilder für Computer Vision oder Audio-Dateien. Diese Daten müssen erst für die Maschine lesbar gemacht werden (Vektorisierung), enthalten aber Kontext und Nuancen, die in keiner Tabelle stehen.

Ein Beispiel für den massiven Einsatz unstrukturierter Bilddaten finden Sie in der Analyse zur KI und dem Ende der Fotografie.

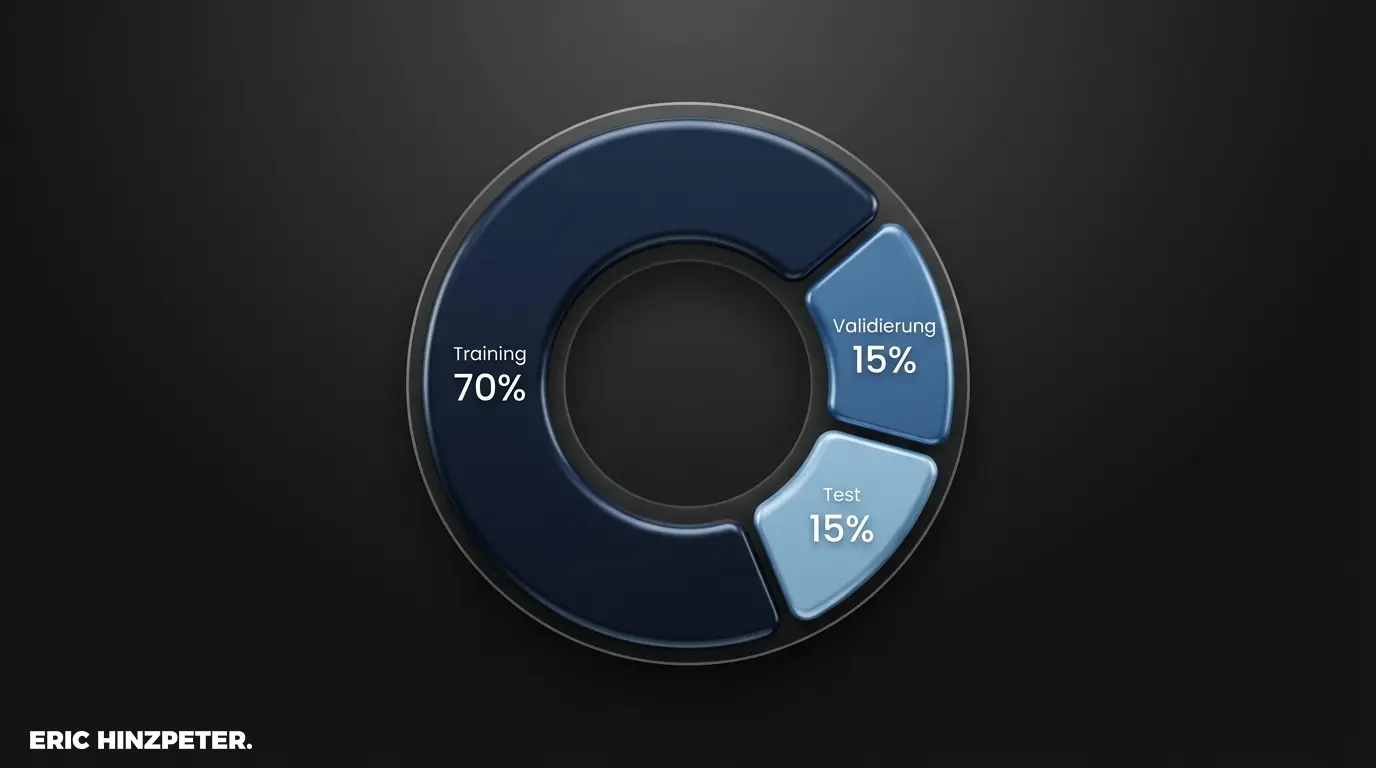

Unterschied zwischen Trainings-, Validierungs- und Testdaten

Hier scheitern die meisten Hobby-Projekte. Man darf ein Modell niemals mit den Daten testen, mit denen man es trainiert hat. Das wäre, als würde man einem Schüler die Lösungen der Klausur schon zum Lernen geben – er versteht den Stoff nicht, er lernt ihn nur auswendig. In der Fachsprache nennt man das „Overfitting“.

Deshalb teilen wir Datensätze rigoros auf:

- Trainingsdaten (ca. 70-80%): Damit lernt das Netz, passt seine Gewichte an.

- Validierungsdaten (ca. 10-15%): Diese nutzt man während des Trainings, um die Architektur feinjustieren (Hyperparameter), aber nicht, um die Gewichte direkt zu lernen.

- Testdaten (ca. 10-15%): Dieser Datensatz bleibt bis ganz zum Schluss im Tresor. Erst wenn das Modell fertig ist, wird es einmalig hiermit konfrontiert, um die echte Performance zu messen.

Wie werden Trainingsdaten beschafft und aufbereitet?

Die Datenbeschaffung ist oft der teuerste Posten im Projekt. Es gibt im Grunde drei Wege: Man bedient sich an Open-Source-Quellen (wie Hugging Face oder Kaggle), man betreibt Web Scraping (was rechtlich zunehmend vermint ist) oder man nutzt proprietäre Unternehmensdaten. Letzteres ist für die meisten Firmen der einzige echte Wettbewerbsvorteil (Moat), da die Modelle selbst zunehmend austauschbar werden (Commodity).

Aber Rohdaten sind nutzlos. Die Datenbereinigung (Cleaning) frisst oft 80% der Projektzeit. Duplikate müssen raus, Formatierungsfehler korrigiert und persönliche Informationen anonymisiert werden. Erst dann beginnt das eigentliche Training – ein mathematischer Prozess, bei dem eine Fehlerfunktion (Loss Function) minimiert wird. Das Modell „liest“ die Datensätze nicht wie ein Buch, es optimiert statistische Parameter, bis der Output zur Erwartung passt.

Wer wissen will, wie man diese Modelle nach dem Training steuert, sollte sich mit Prompt Engineering befassen.

Synthetische Trainingsdaten als Alternative

Wir laufen auf ein Problem zu: Das Internet ist fast leer gelesen. Hochwertige menschliche Textdaten werden knapp. Die Industrie setzt deshalb zunehmend auf synthetische Daten – also Daten, die von einer KI generiert wurden, um eine andere KI zu trainieren. In der Robotik oder beim autonomen Fahren ist das Standard (Simulationen).

Das Risiko dabei ist der sogenannte „Model Collapse“. Wenn Modelle nur noch von Modellen lernen, degeneriert die Qualität über Generationen, ähnlich wie bei einer Fotokopie einer Fotokopie. Synthetik ist ein mächtiges Werkzeug, aber kein Allheilmittel für fehlende Realitäts-Daten.

Pro-Tipp: Fine-Tuning Strategie

Bevor Sie riesige Budgets für das Training eigener Modelle aufwenden (Pre-Training), prüfen Sie RAG (Retrieval Augmented Generation) oder Fine-Tuning. Oft reicht es, einem bestehenden starken Modell (Foundation Model) nur einen sehr kleinen, hochqualitativen Datensatz Ihrer Domäne zu zeigen, um exzellente Ergebnisse zu erzielen.

Rechtliche Aspekte: Datenschutz und Urheberrecht

Hier kollidiert die technologische Realität frontal mit der Gesetzgebung. Das Training von KI mit personenbezogenen Daten ist unter der DSGVO ein Minenfeld. Das „Recht auf Vergessenwerden“ ist technisch kaum umzusetzen – man kann ein einzelnes Datum nicht einfach aus einem trainierten neuronalen Netz „löschen“ (Machine Unlearning ist noch Forschungsgebiet).

Noch hitziger ist die Debatte um das Urheberrecht. Große Anbieter argumentieren oft mit „Fair Use“, wenn sie urheberrechtlich geschützte Werke zum Training nutzen. Verlage und Künstler sehen das anders. Wer heute Modelle auf unklaren Datenbasen baut, riskiert, dass er morgen sein Modell löschen muss, wenn die Rechtsprechung (z.B. der AI Act der EU) hart durchgreift. Datenschutz ist keine Compliance-Übung, sondern Investitionsschutz.

Für tiefergehende rechtliche Einschätzungen lohnt sich ein Blick in die offiziellen Texte zur DSGVO.

Fazit: Hochwertige Daten als Treibstoff für KI

Wir bewegen uns weg von der Phase „Mehr Daten sind besser“ hin zu „Bessere Daten sind besser“. Die Zukunft gehört kuratierten, sauberen Datensätzen („Small Language Models“), die spezifische Probleme lösen, statt das gesamte Internet auswendig zu lernen. Wer heute saubere Datenprozesse aufsetzt, baut das Fundament für die Automation von morgen. Wer nur Daten in einen Speicher kippt, baut lediglich ein digitales Müllhalden-Archiv.