Was ist ein Prompt? Definition und Erklärung

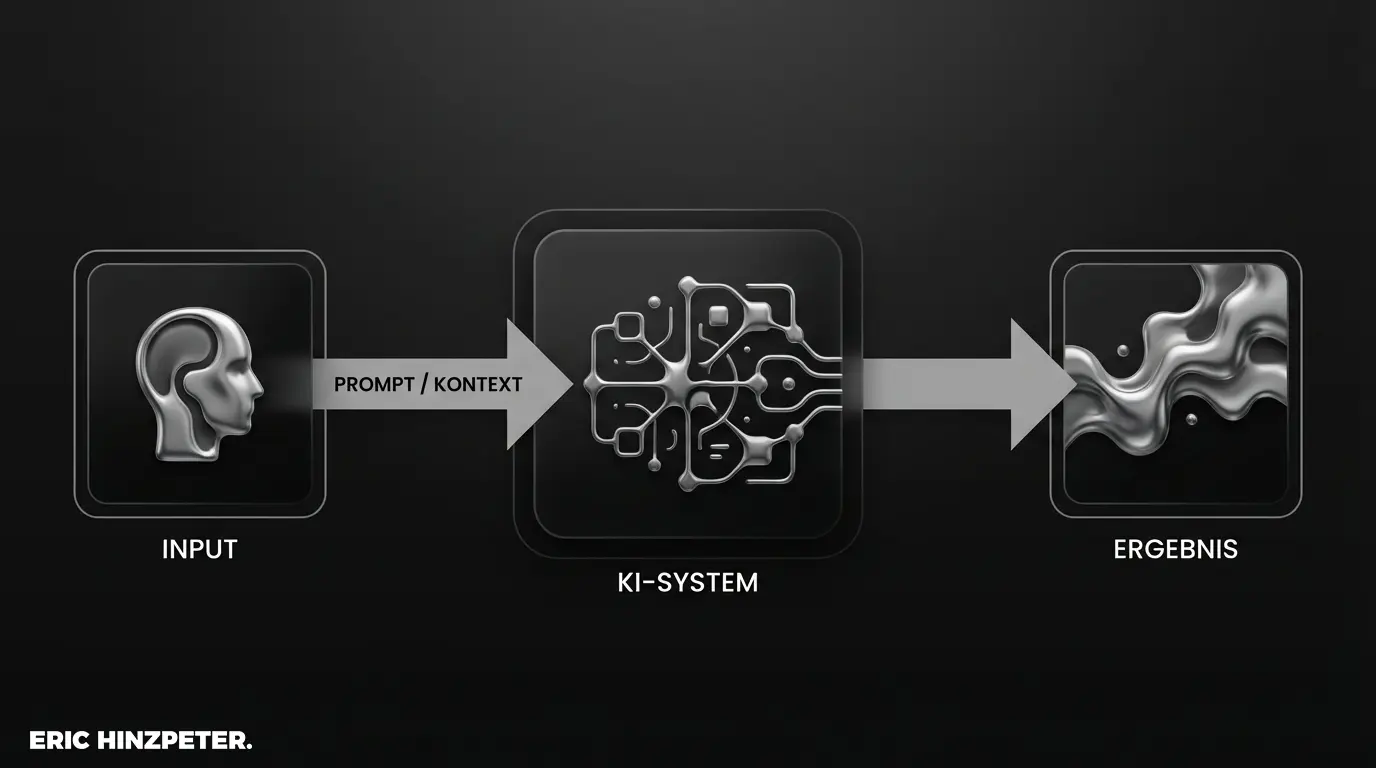

Systemisch betrachtet ist ein Prompt der Eingabebefehl, mit dem du eine Künstliche Intelligenz steuerst. Er fungiert als Schnittstelle zwischen deiner Intention und dem Output der Maschine. Anders als in der klassischen Programmierung, die auf Syntax-Code basiert, formulierst du einen Prompt in natürlicher Sprache.

Die Logik folgt einem klaren Prinzip: Input bestimmt Output. Man kann es mit einem Briefing an einen externen Dienstleister vergleichen. Wenn die Anweisung vage bleibt („Mach mal ein Konzept“), ist das Ergebnis zufällig. Definierst du jedoch Rahmenbedingungen, Zielgruppe und Format („Erstelle ein Sicherheitskonzept für Cloud-Infrastruktur im Bankensektor“), liefert das System präzise Ergebnisse. Genau so arbeiten Sprachmodelle und Generative KI. Sie benötigen eine klare Anweisung – den Prompt –, um Text, Bild oder Code effizient zu erzeugen.

Oft wird der Begriff auf reine Text-Eingaben reduziert. Doch die Architektur dahinter ist komplexer: Der Prompt setzt den Kontext, in dem das neuronale Netz operiert.

Du willst tiefer in die Systematik einsteigen? Für eine detaillierte Analyse lies unseren Guide zu Prompting Grundlagen.

Warum ist Prompt Engineering so wichtig?

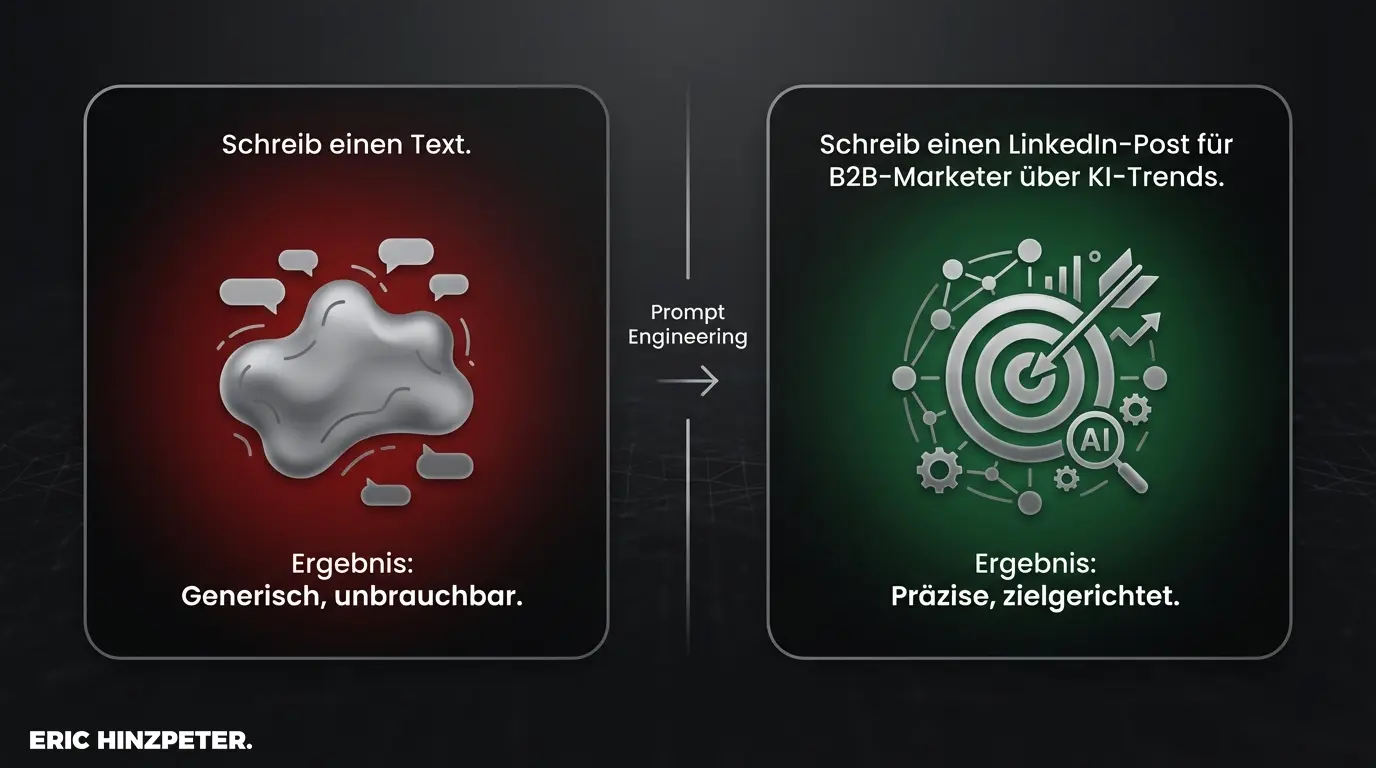

Hier greift ein fundamentales Prinzip der Informatik: „Garbage In, Garbage Out“. Wenn die Qualität der Eingabe mangelhaft ist, kann selbst das leistungsfähigste Modell keine validen Ergebnisse liefern. Das methodische Konstruieren und Iterieren dieser Eingaben bezeichnet man als Prompt Engineering.

Es geht hierbei nicht um kreatives Schreiben, sondern um technische Präzision. Prompt Engineering ist die Kompetenz, die Maschine so zu kalibrieren, dass Halluzinationen minimiert und die Relevanz maximiert wird. Die Optimierung deiner Prompts ist ein Effizienz-Hebel: Statt in endlosen Korrekturschleifen festzuhängen, erzwingst du durch eine klare Struktur sofort ein verwertbares Ergebnis.

Die Struktur eines perfekten Prompts

Ein valider Prompt folgt fast immer einer modularen Struktur. Man kann dies als Baukasten-Architektur verstehen. Wenn du dieses System verinnerlichst, wirst du unabhängig vom spezifischen Tool reproduzierbare Resultate erzielen.

Insight: Die 4-W-Logik

Prüfe jeden Prompt auf diese vier Komponenten: Wer (Rolle), Was (Aufgabe), Wie (Format) und Wofür (Kontext). Fehlt einer dieser Parameter, muss die KI auf Wahrscheinlichkeiten zurückgreifen – was oft zu Mittelmaß führt.

Kontext, Persona und Ausgabeformat

Damit die KI nicht nur statistisch wahrscheinliche Worte aneinanderreiht, sondern in deinem Sinne agiert, benötigt sie drei Steuerungsgrößen:

- Persona: Mit dem Parameter „Act as…“ gibst du der KI eine Rolle vor. Ein „Senior Marketing-Stratege“ nutzt ein anderes Vokabular als ein „Junior Texter“.

- Kontext: Liefere die Hintergründe. Wer ist die Zielgruppe? Was ist das strategische Ziel? Ohne Kontext bleibt die Antwort generisch.

- Ausgabeformat: Definiere das Zielformat. Benötigst du eine Tabelle, eine strukturierte Liste, Python-Code oder Fließtext? Das Ausgabeformat diktiert die Struktur des Outputs.

Die Rolle von Parametern und Tokens

Für das technische Verständnis ist ein Blick unter die Haube nötig: KI-Modelle verarbeiten keine Wörter, sondern Tokens. Man kann Tokens als semantische Einheiten oder Silben verstehen. Ein Wort entspricht im Schnitt 0,75 Tokens. Das ist die Recheneinheit, die über Kosten und Kontext-Limit entscheidet.

Zusätzlich lassen sich Modelle über technische Parameter feinjustieren. Der bekannteste ist die „Temperature“. Ein hoher Wert erhöht die Varianz (Kreativität), ein niedriger Wert sorgt für deterministische, faktenorientierte Antworten.

Wichtige Techniken: Zero-Shot vs. Few-Shot

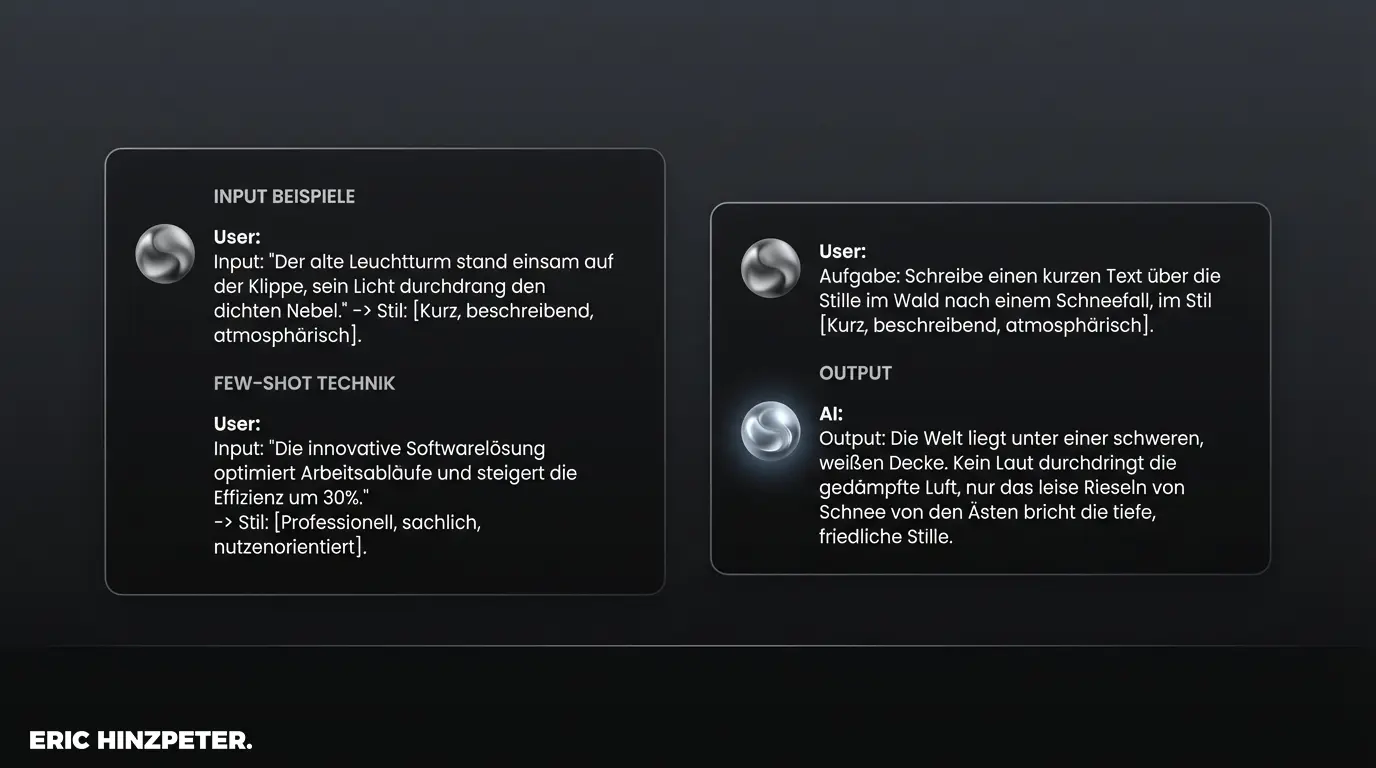

In der KI-Architektur unterscheiden wir zwei wesentliche Methoden der Instruktion:

Zero-Shot bedeutet, du stellst der KI eine Aufgabe ohne Referenzdaten.

Beispiel: „Schreibe einen Tweet über SEO.“

Few-Shot bedeutet, du lieferst der KI Referenzbeispiele (Shots), um das Muster vorzugeben.

Beispiel: „Schreibe einen Tweet über SEO. Orientiere dich an diesem strukturellen Aufbau: [Beispiel 1], [Beispiel 2].“

Die Analyse zeigt: Few-Shot Prompts liefern fast immer qualitativ hochwertigere Ergebnisse, da die KI das implizite Muster der Beispiele adaptiert.

Tipps für bessere ChatGPT Prompts

Bei der Nutzung von ChatGPT oder ähnlichen Tools zur Textgenerierung liegt der Fehler oft im linearen Denken. Der erste Output ist selten das Endergebnis. Die Stärke von LLMs (Large Language Models) liegt in der Iteration.

Nutze den Chatbot als Sparringspartner: „Die Argumentation ist schlüssig, aber kürze den zweiten Absatz und schärfe den Tonfall.“ Durch dieses iterative Eingreifen näherst du dich dem Optimum an. Relevante Werkzeuge hierfür findest du auch in unserer Analyse der Top KI-Tools im Content Marketing.

Pro-Tipp: Strategie vor Taktik

Nutze ChatGPT nicht nur zur Exekution, sondern zur Validierung. Ein Prompt wie „Analysiere meine Argumentation auf logische Lücken“ bietet oft mehr strategischen Mehrwert als die reine Textproduktion.

Anleitung für Bild-KI Prompts wie Midjourney

Während Text-KIs auf Logik reagieren, benötigen Systeme zur Bildgenerierung wie Midjourney oder DALL-E eine deskriptive, visuelle Syntax. Hier sprechen wir von Prompt-Design.

Statt grammatikalischer Sätze funktionieren hier Aneinanderreihungen von Stil-Parametern am besten: „Cinematic lighting, photorealistic, 8k resolution, cyberpunk style“. Die visuelle Semantik wiegt hier schwerer als die grammatikalische Korrektheit.

Häufige Fehler bei der Eingabeaufforderung vermeiden

Auch wenn moderne Systeme robust sind, führen strukturelle Fehler bei der Eingabeaufforderung oft zu suboptimalen Ergebnissen:

- Logische Widersprüche: „Schreibe ausführlich, aber fasse dich kurz.“ Solche Paradoxien destabilisieren den Output.

- Fehlender Kontext: Wenn die Zielgruppe nicht definiert ist, wählt die KI den statistischen Durchschnitt – das Ergebnis wirkt generisch.

- Kognitive Überladung: Zu viele Instruktionen in einem einzigen Prompt können dazu führen, dass Aspekte „vergessen“ werden. Zerlege komplexe Aufgaben in sequentielle Schritte (Chain-of-Thought).

Fazit: Die Zukunft der Mensch-Maschine-Kommunikation

Prompts sind mehr als einfache Befehle; sie sind die fundamentale Schnittstelle der Interaktion mit intelligenten Systemen. Während die Künstliche Intelligenz immer adaptiver wird, bleibt die Fähigkeit zur präzisen Instruktion eine Schlüsselkompetenz. Wer die Logik der Eingabe beherrscht, kontrolliert die Qualität des Ergebnisses. Es lohnt sich, das „Prompten“ nicht als Workaround, sondern als strukturiertes Kommunikationsmodell zu verstehen.