Was ist ein Token? – Eine einfache Erklärung

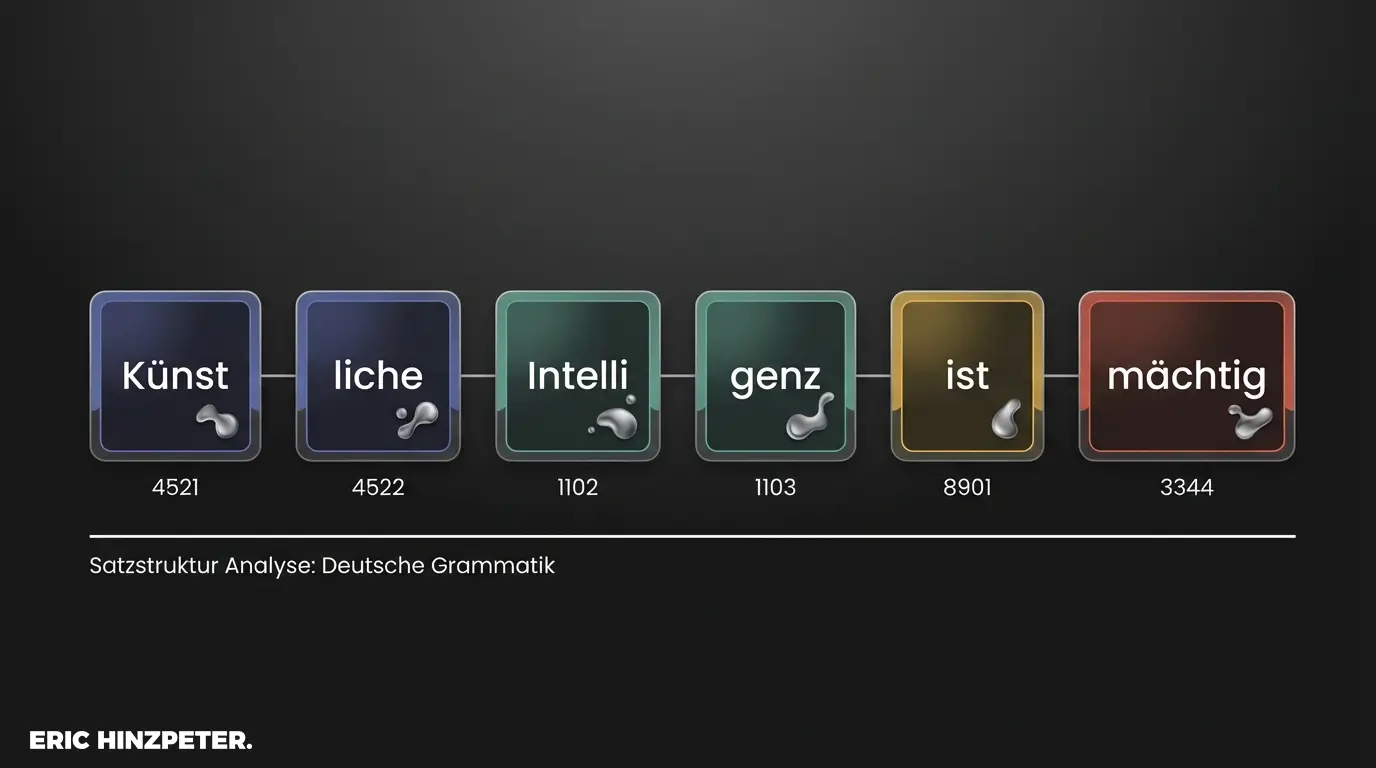

Wer die Architektur von Large Language Models (LLMs) wie GPT-5 oder Claude verstehen will, muss sich von der menschlichen Wahrnehmung von Sprache lösen. Maschinen lesen keine Wörter, sie verarbeiten Tokens. Systemisch betrachtet sind Tokens die atomaren Grundeinheiten der Informationsverarbeitung. Ein Token ist dabei nicht zwangsläufig deckungsgleich mit einem Wort. Oft handelt es sich um Silben, Fragmente oder einzelne Satzzeichen. Das Modell zerlegt (tokenisiert) den Input in diese kleinsten sinnvollen Sequenzen, um sie mathematisch nutzbar zu machen. Ein häufiges Missverständnis ist die direkte Gleichsetzung. Die technische Faustformel für die Kalkulation lautet:

Im Englischen: 1.000 Token entsprechen etwa 750 Wörtern.

Im Deutschen: Aufgrund der komplexeren Struktur und zahlreicher Komposita ist die „Token-Dichte“ höher. Hier entsprechen 1.000 Token eher 600 bis 700 Wörtern.

Diese Fragmentierung ist kein Zufall, sondern eine Notwendigkeit der Vektorisierung. Nur durch die Zuweisung einer numerischen ID wird Sprache für den Algorithmus greifbar.

Wer saubere Prompts entwickeln will, muss diese Granularität berücksichtigen.

Für die Analyse der eigenen Texte lohnt sich ein Blick auf Tools wie den offiziellen Tokenizer von OpenAI (externer Link). Hier wird die Logik der Zerlegung transparent.

Tokenisierung: Wie LLMs Sprache verarbeiten

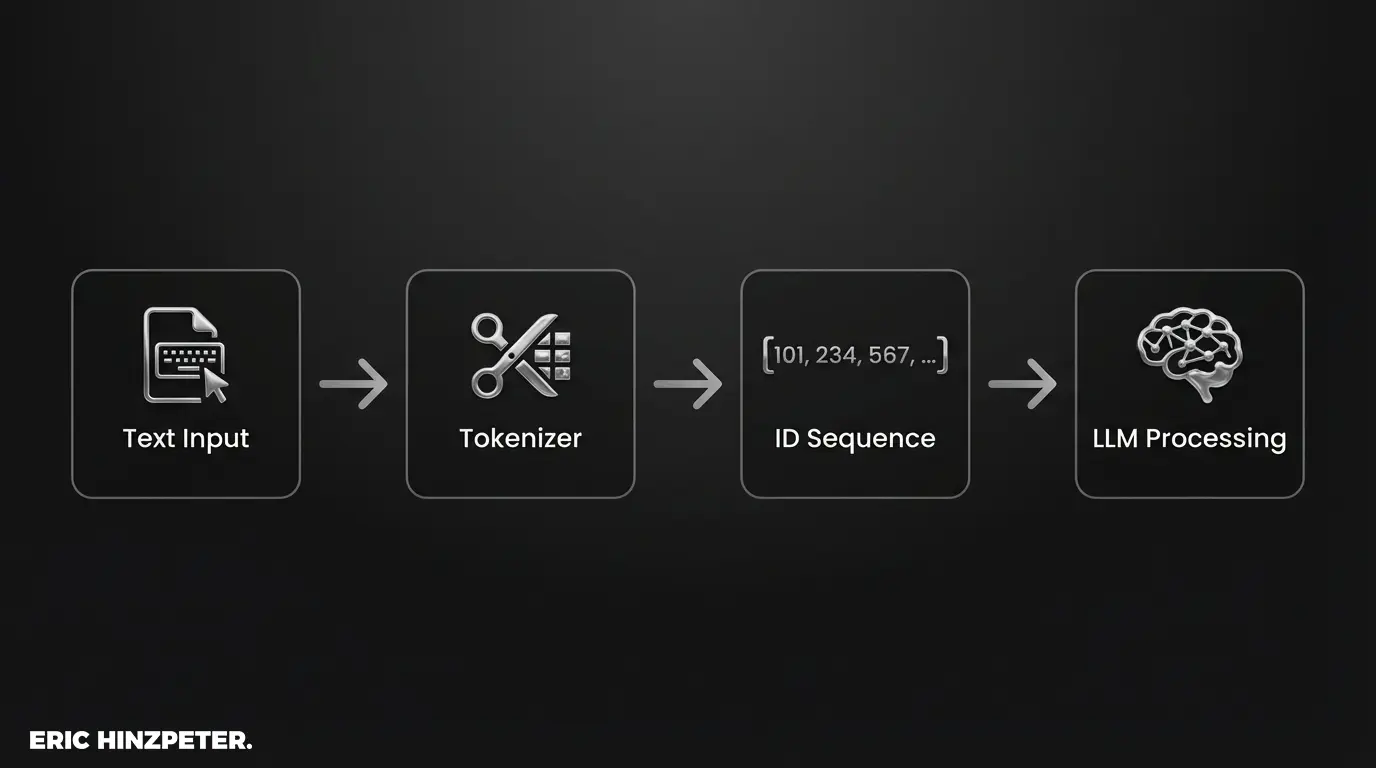

Die Tokenisierung ist der Gatekeeper jeder KI-Architektur. Sie übersetzt unstrukturierte Sprache in strukturierte Daten. Ein Computer kann keine semantische Bedeutung „fühlen“; er benötigt Vektoren – mathematische Repräsentationen im multidimensionalen Raum.

Der Prozess folgt einer klaren Kausalkette:

1. Input: Der User gibt Text ein.

2. Tokenisierung: Der Text wird in definierte Fragmente zerlegt.

3. ID-Zuweisung: Jedem Fragment wird eine Zahl aus dem fixen Vokabular des Modells zugewiesen.

4. Vektorisierung: Die Zahlen werden in Vektoren umgewandelt, die die semantische Beziehung der Tokens zueinander abbilden.

Ein oft übersehener Faktor ist die Sprach-Effizienz. Während das Englische oft 1:1 in Tokens übersetzt wird, erzeugt die deutsche Sprache mit ihren zusammengesetzten Begriffen (z.B. „Donaudampfschifffahrtskapitän“) eine deutlich höhere Token-Last. Das Resultat: Deutsche Inputs belegen mehr Context Window und verursachen höhere Inferenzkosten als englische Pendants.

Verstehst du diese Mechanik, kannst du durch präzises Prompt Engineering nicht nur die Qualität der Ausgabe steigern, sondern auch die Latenzzeiten deiner KI-Anwendungen optimieren.

Bedeutung von Token für Pricing & Limits

Tokens sind nicht nur technische Einheiten, sie sind eine ökonomische Metrik. Sie definieren sowohl die Kostenstruktur als auch die Leistungsgrenzen deiner Anwendung.

Das Context Window (Gedächtnis)

Jedes LLM verfügt über ein limitiertes Context Window. Dies ist die maximale Menge an Tokens, die das Modell gleichzeitig verarbeiten kann (Input + Output). Ist der Puffer voll, beginnt der Information Loss – die KI „vergisst“ den Anfang des Gesprächs.

- Frühe Modelle: 4.000 Token (ca. 3.000 Wörter)

- Moderne Modelle: 128.000 bis 1 Million Token (ganze Buchbände)

Pricing: Die Kosten der Intelligenz

Die Abrechnung erfolgt bei Providern wie OpenAI oder Anthropic meist im Modell „Cost per 1k Tokens“. Dabei wird differenziert: Output-Tokens (Generierung) sind oft teurer als Input-Tokens (Analyse). Effizienz im Input korreliert also direkt mit den Betriebskosten.

Pro-Tipp: Ineffizienzen vermeiden

Die Skalierung deckt Schwächen in der Architektur auf. Ein unsauberer System-Prompt, der bei jeder Anfrage unnötige Füllwörter mitschleift, belastet bei tausendfacher Ausführung das Budget massiv. Reduziere deine Prompts auf die logische Essenz – jedes gesparte Token steigert die Marge.

Für tiefergehende Analysen zu aktuellen KI-Entwicklungen empfehle ich einen Blick in meinen Blog.

Tokenisierung: Die Zukunft digitaler Vermögenswerte

Das Konzept der Tokenisierung ist die Quantifizierung von Realität. Sie macht LLM Information und Sprache berechenbar. In einer automatisierten Ökonomie wird die Fähigkeit, diese Einheiten zu managen, zur Kernkompetenz. Wer versteht, wie Informationen in Tokens zerlegt und prozessiert werden, begreift die fundamentale Logik moderner digitaler Architekturen.