Sparen wir uns die gespielte Überraschung. Dass Apple seinen „Walled Garden“ öffnet, war keine Frage des Ob, sondern des Wann. Cupertino hat am 12. Januar 2026 eine mehrjährige Partnerschaft mit Google offiziell bekannt gegeben, um Google Gemini als Kern der nächsten Generation der Apple Foundation Models tief in das iOS-Betriebssystem zu integrieren.

Die Logik dahinter ist simpel: Apple hat das Rennen um die generative KI mit seinem internen Projekt „Ajax“ nicht rechtzeitig gewonnen. Während sich der Markt im Jahr 2026 rasant entwickelt, markiert der Deal das Eingeständnis, dass Apple externe Hilfe benötigt. Die Integration von Gemini ist kein bloßes Feature-Update. Es ist der Versuch, eine strategische Lücke mit der derzeit leistungsfähigsten Technologie-Basis zu füllen.

Apple integriert Google Gemini in Siri: Der komplette Überblick

Der Apple Google Deal markiert eine Zeitenwende. Bisher galt bei Apple das Mantra: Wir machen alles selbst. Doch bei generativer KI stößt dieser Ansatz an seine Grenzen. Die aktuellen Technologie Nachrichten bestätigen: Apple nutzt Google Gemini 3 mit schätzungsweise 1,2 Billionen Parametern als Fundament, um Siri wieder konkurrenzfähig zu machen.

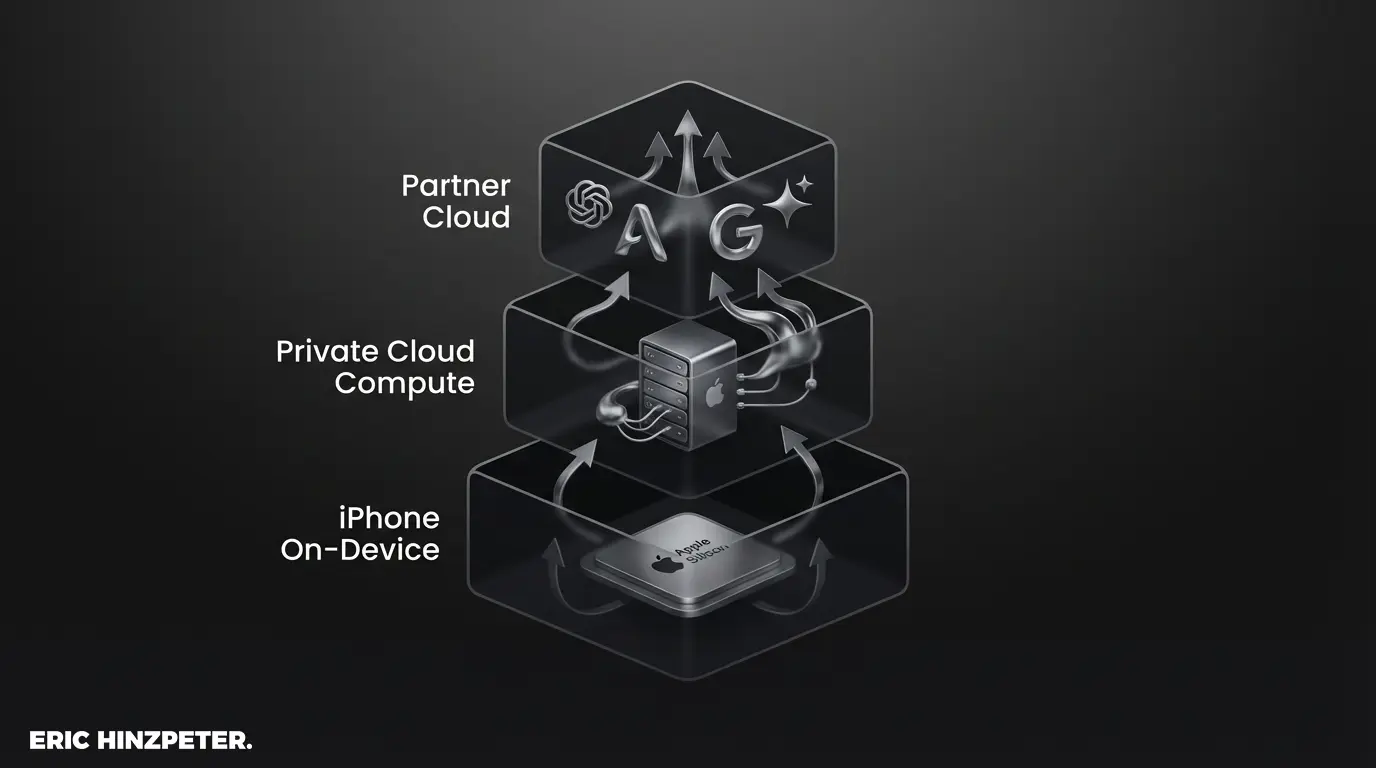

Die Umsetzung folgt einer hybriden Strategie. Apple Intelligence fungiert als Basis-Layer. Für einfache Aufgaben wie Timer oder Smart-Home-Steuerung bleibt die Verarbeitung lokal auf dem Gerät. Sobald die Anfrage aber komplexer wird – also echtes Weltwissen, kreative Textgenerierung oder agentische Aufgaben erfordert – greift Siri auf die Cloud-Infrastruktur zu.

Nach der Integration von OpenAI (ChatGPT), die weiterhin als Opt-in für spezifische Aufgaben besteht, ist die Google-Partnerschaft der finale Schritt, um Gemini als Standard-Modell ins iPhone zu holen. Für Apple bedeutet das jährliche Lizenzkosten von etwa 1 Milliarde US-Dollar an Google – ein Wendepunkt, da Google bisher primär als Zahler für den Suchmaschinen-Status bekannt war.

Pro-Tipp: Den Überblick behalten

Die KI-Landschaft ändert sich wöchentlich. Was heute als Gerücht gilt, ist morgen Standard in iOS. Wer hier strategisch am Ball bleiben will, sollte nicht auf die Keynotes warten, sondern die Architektur-Entscheidungen dahinter verstehen. Genau diese Analysen teile ich regelmäßig in meinem Blog.

Warum Apple auf Google Gemini statt eigener KI setzt

Warum baut das wertvollste Unternehmen der Welt diese Technologie nicht einfach selbst? Die Antwort liegt in der Zeit und den Daten. Generative künstliche Intelligenz benötigt Jahre an Training und Milliarden an Parametern.

Apples Projekt „Ajax“ konnte mit der Innovationsgeschwindigkeit von Google und OpenAI nicht mithalten. Im harten KI Wettbewerb zählt Time-to-Market mehr als Perfektion. Hätte Apple weiter nur auf eigene Technik gesetzt, wäre Siri im Vergleich zu Modellen wie GPT-5.2 oder Claude 4.5 komplett irrelevant geblieben.

Es ist eine strategische Neuausrichtung. Google besitzt mit seiner Cloud-Infrastruktur eine Rechenpower für Maschinelles Lernen, die Apple durch die Partnerschaft nun direkt für seine Foundation Models nutzt.

Für Maschinelles Lernen auf diesem Niveau braucht es mehr als nur gute Hardware im Endgerät – es braucht eine massive Backend-Struktur, die Google über Jahre aufgebaut hat.

Apple Intelligence: Die Rolle von Google im Apple-Ökosystem

Um die Tragweite dieses Deals zu verstehen, müssen wir uns die Architektur von Apple Intelligence im Jahr 2026 ansehen. Sie ist in drei Schichten unterteilt:

- On-Device KI: Läuft auf dem A19- oder A20-Chip (mindestens 8 GB RAM erforderlich). Schnell und privat. Erledigt lokale Suchen und einfache Befehle.

- Private Cloud Compute (PCC): Apples Server-Lösung auf Basis eigener Silicon-Chips. Hier laufen spezialisierte Adapter-Modelle auf Gemini-Basis für Anfragen, die persönlichen Kontext erfordern, aber sicher verarbeitet werden müssen.

- Google Gemini Cloud: Für komplexes Weltwissen und Logik ohne privaten Datenbezug wird direkt die Gemini-Infrastruktur delegiert.

Besonders wichtig ist, dass Gemini 3 nun die technologische Basis bildet, während Apple durch PCC sicherstellt, dass keine Nutzerdaten für das Training von Google-Modellen verwendet werden.

Wer tiefer in die Unterscheidung zwischen einfachen Assistenten und echten, handelnden Systemen eintauchen will, sollte sich den Unterschied zwischen Assistenten und Agenten ansehen. Mit iOS 26 entwickelt sich Siri durch agentische Fähigkeiten erstmals in diese Richtung.

Neue Funktionen: Was Siri dank Gemini bereits kann

Was bedeutet das konkret für dich als Nutzer? Mit der Siri Verbesserung durch Gemini 3 ist der Sprachassistent endlich fähig, kontextübergreifend zu agieren. Siri ist keine bloße Suchmaschine mehr, sondern ein proaktiver Helfer.

Dank der On-Screen Awareness von Gemini kann Siri nun interpretieren, was du gerade auf dem Display siehst. „Sende das Foto an meine Mutter“ funktioniert app-übergreifend, da Siri das Motiv und den Kontakt erkennt. Auch die Live-Übersetzung in FaceTime erfolgt durch Gemini 3 Flash nahezu in Echtzeit mit deiner eigenen Stimme.

Ein riesiger Sprung ist die Dokumentenverarbeitung: Siri korreliert Informationen aus Mails und Kalendern, um proaktiv Restaurantreservierungen oder Fahrzeiten vorzuschlagen. Allerdings gibt es einen Haken: Die Hardware.

Die volle Apple Intelligence benötigt zwingend 8 GB RAM. Während der A17 Pro den Einstieg markierte, ist der A19-Chip der erste, der spezifisch für die multimodalen Anforderungen von Gemini optimiert wurde. Ältere Geräte werden von vielen dieser Features ausgeschlossen.

Das ist besonders relevant für modernes Content Marketing, wo die schnelle Erstellung von Entwürfen direkt auf dem Mobilgerät zum Standard wird.

Siri Gemini vs. ChatGPT: Welcher KI-Assistent ist besser?

Apple setzt auf ein duales System. Während Google Gemini 3 die fundamentale Basis für die Apple Foundation Models stellt, bleibt ChatGPT als spezialisierte Option für kreatives Schreiben oder Expertenwissen erhalten.

Der Unterschied liegt in der Systemtiefe. Gemini ist nativ in die Architektur und die Private Cloud integriert. ChatGPT bleibt ein Opt-In-Dienst. Laut Benchmarks vom Januar 2026 liegt Gemini 3 Pro in der Multimodalität extrem nah an GPT-5.2, während Gemini 3 Flash durch enorme Geschwindigkeit bei hoher Effizienz überzeugt.

Zudem profitiert Apple von der Rechenleistung der Google Cloud, was eine flüssigere Benutzererfahrung ermöglicht.

Pro-Tipp: Fachbegriffe verstehen

LLM, Multimodal, RAG, Agenten – die Begriffe fliegen uns gerade nur so um die Ohren. Bevor du dich für ein Tool entscheidest, lohnt ein Blick in mein Glossar, wo ich diese Buzzwords in verständliche Logik übersetze.

Um das Maximum aus beiden Modellen herauszuholen, ist das Verständnis von Prompting-Grundlagen essenziell. Denn auch die beste KI liefert nur Müll, wenn der Input unpräzise ist.

Nach Siri-Kritik: Kann Google Gemini den Sprachassistenten retten?

Jahrelang war Siri das Sorgenkind. Mit der Integration von Gemini 3 hat Apple das Ruder herumgerissen. Es ist mehr als ein Pflaster; es ist ein neues Gehirn. Siri kann nun komplexe Aufgaben über mehrere Apps hinweg lösen.

Langfristig versucht Apple jedoch, die Kontrolle zurückzugewinnen. Berichte zeigen, dass Apple bereits an eigenen KI-Server-Chips arbeitet, um die Abhängigkeit von Google bis Ende 2026 wieder zu reduzieren. Bis dahin bleibt die Partnerschaft jedoch das lebensnotwendige Rückgrat für das iPhone.

Datenschutz und Sicherheit: Google Gemini auf dem iPhone

Apple hält an seinem Privacy-Versprechen fest. Die Google Gemini Integration wird durch das Private Cloud Compute (PCC) abgesichert. Nutzerdaten für persönliche Anfragen werden auf Apple-eigenen Servern verarbeitet und sofort aus dem RAM gelöscht.

Google hat keinen Zugriff auf diese Daten für das Training eigener Modelle. Nutzer können zudem im „Apple Intelligence Report“ unter iOS 26 minutengenau einsehen, welche Daten warum verarbeitet wurden. Datenschutz beim iPhone bleibt somit trotz externer Technologie-Basis ein zentrales Verkaufsargument.

Wann kommt das Siri-Update mit Google Gemini?

In den USA ist die Integration bereits gestartet. In der EU und Deutschland ist die Situation komplexer. Während Apple Intelligence seit März 2025 in Deutsch verfügbar ist, verzögern sich fortgeschrittene agentische Funktionen wie die On-Screen Awareness aufgrund des Digital Markets Act (DMA).

Das Update iOS 26.4 im Frühjahr 2026 soll weitere Funktionen bringen, wobei Apple weiterhin mit den EU-Regulierern über Interoperabilitätsauflagen verhandelt.

FAQ: Häufige Fragen zu Siri und Google Gemini

Wann kommt Gemini auf das iPhone?

Die Partnerschaft wurde im Januar 2026 offiziell verkündet. Die tiefgreifende Integration der Gemini-basierten Foundation Models erfolgt schrittweise mit den aktuellen iOS 26 Updates.

Was ist der Unterschied zwischen Apple Intelligence und Gemini?

Apple Intelligence ist das Gesamtsystem von Apple. Im Jahr 2026 basiert die zugrunde liegende Modell-Technologie (Foundation Models) jedoch offiziell auf Google Gemini.

Kostet Siri mit Gemini Geld?

Die Basis-Integration in iOS ist kostenlos. Nutzer können sich jedoch per Opt-in für zusätzliche Dienste wie ChatGPT oder spezialisierte Gemini-Features entscheiden.

Ist Siri jetzt schlauer?

Ja. Durch die Nutzung von Gemini 3 mit 1,2 Billionen Parametern und agentischen Fähigkeiten kann Siri nun proaktiv handeln und Bildschirminhalte verstehen.

Fazit & Ausblick

Die Integration von Gemini in Siri ist für den Nutzer eine gute Nachricht: Das iPhone ist im Jahr 2026 endlich ein echtes KI-Werkzeug. Wir bekommen Zugriff auf Weltklasse-KI, die tief im System verwurzelt ist.

Strategisch ist es ein notwendiger Wendepunkt. Apple ist vom Innovator zum Integrator geworden, um den Anschluss nicht zu verlieren. Mit der Einführung von iOS 26 und dem kommenden iPhone 18 Fold zeigt Apple, dass die Zukunft in der Kombination aus lokaler Hardware-Power (A19/A20) und externer Cloud-Intelligenz liegt.

Pro-Tipp: Strategische Beratung

Die Wahl des richtigen KI-Modells ist für Unternehmen keine Geschmacksfrage, sondern eine der Architektur und Datensicherheit. Wenn du wissen willst, wie du Gemini oder ähnliche Tools produktiv und sicher in deine Prozesse integrierst, finden wir gemeinsam die logische Struktur.