Was ist Context Engineering?

Wenn die Ergebnisse Ihrer KI inkonsistent sind, liegt das selten am Prompt, sondern an der Informationsarchitektur. Hier setzt Context Engineering an: der strategische und iterative Prozess zur Optimierung der Leistung von LLMs. Es geht weit über einfaches Prompt Engineering hinaus und fokussiert sich auf die gezielte Verwaltung des gesamten Kontextfensters, um die KI mit den exakt richtigen Daten zu versorgen und Halluzinationen zu vermeiden.

Es ist die technische Disziplin, die Informationsumgebung für ein Large Language Model (LLM) so zu gestalten, dass es überhaupt erst in der Lage ist, valide Antworten zu liefern. Es geht nicht um deinen Befehl, sondern um das „Arbeitsgedächtnis“, das du der KI zur Verfügung stellst. Wenn du hier schlampst, brauchst du dich über Halluzinationen nicht zu wundern.

Besonders schmerzhaft wird dies bei KI-Agentensystemen. Ein einfacher Chatbot kann einen Fehler oft durch einen neuen Prompt korrigieren. Ein autonomer Agent, der auf Basis falscher Informationen Entscheidungen trifft, läuft jedoch gnadenlos in eine Sackgasse. Wenn dein Input aus unstrukturiertem Datenmüll besteht, hilft auch der eloquenteste Prompt nichts. Context Engineering ist die Architektur der Informationszufuhr, bevor die eigentliche Generierung durch Künstliche Intelligenz beginnt.

Um die technischen Grundlagen zu verstehen, musst du dir die Basiseinheit der Verarbeitung ansehen: Token. Wenn du nicht verstehst, wie Modelle Informationen zählen und gewichten, wirst du beim Context Engineering scheitern. Das ist im Grunde einfache Mathematik, wird aber gerne ignoriert.

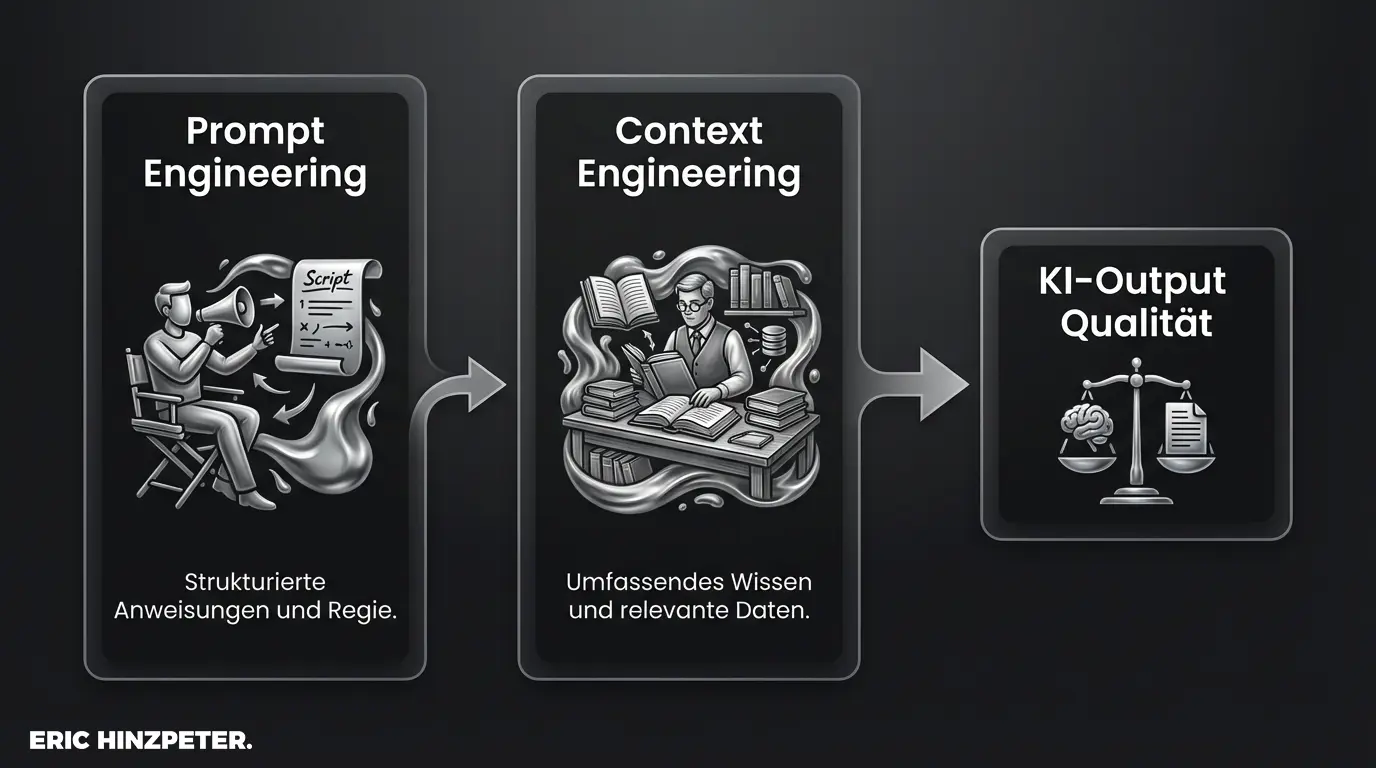

Context Engineering vs. Prompt Engineering: Der Unterschied

Wir können jetzt weiter Buzzword-Bingo spielen oder uns mal kurz die tatsächliche Logik anschauen. Du musst sauber trennen: Prompt Engineering ist die Kunst der Anweisung. Es ist dein Befehl: „Fasse diesen Text zusammen“. Context Engineering ist die Bereitstellung des Textes selbst und des Hintergrundwissens, das du für die Zusammenfassung benötigst.

Ein Blick auf die Struktur zeigt dir die Unterschiede:

| Merkmal | Prompt Engineering | Context Engineering |

|---|---|---|

| Fokus | Instruktion (Wie frage ich?) | Daten (Was weiß das Modell?) |

| Ziel | Optimierung der Aufgabe | Optimierung der Umgebung |

| Limitierung | Fähigkeit des Modells (Reasoning) | Größe des Kontextfensters |

Moderne Large Language Models benötigen beides. Wenn du versuchst, fehlendes Wissen durch aggressives Prompting zu kompensieren, provozierst du Halluzinationen. Wenn du perfekten Kontext lieferst, aber deine Instruktion unklar ist, bleibt das Ergebnis vage. Die Architektur entscheidet über den Erfolg, nicht das einzelne Wort.

Für einen tieferen Einstieg in die Befehlsseite empfehle ich dir meinen Artikel zum Prompt Engineering.

Das Kernproblem: Herausforderungen des Context Windows

Das größte technische Hindernis in der aktuellen KI-Entwicklung ist das Kontextfenster. Das ist der Speicherplatz, den ein Modell während einer einzigen Konversation „im Kopf“ behalten kann. Viele glauben fälschlicherweise, man könnte einfach ganze Unternehmens-Wikis in den Prompt kopieren. Das ist naiv.

Erstens gibt es ein hartes Token-Limit. Ist dein Fenster voll, schneidet das Modell gnadenlos ab – meistens am Anfang (Vergessen). Zweitens – und das ist perfider – gibt es das „Lost-in-the-Middle“-Phänomen. Untersuchungen zeigen, dass LLMs Informationen am Anfang und am Ende des Kontextes sehr gut abrufen, aber Details in der Mitte der Datenmenge oft ignorieren. Je voller das Fenster, desto unzuverlässiger wird die Verarbeitung der mittleren Daten.

Um effektiv Halluzinationen vermeiden zu können, darfst du das Fenster nicht als unendlichen Lagerraum betrachten, sondern als extrem teure, begrenzte Arbeitsfläche.

Auswirkungen auf autonome KI-Agentensysteme

Wenn du von einfachen Chatbots zu autonomen Agenten wechselst, wird das Kontext-Problem existenziell. Dein Agent führt Aufgaben in Schleifen aus: Er plant, handelt, beobachtet das Ergebnis und plant neu. Dabei muss er sich an sein ursprüngliches Ziel erinnern. Wenn das Kontextfenster durch irrelevante Zwischenergebnisse oder Logs geflutet wird, verdrängt dieser „Lärm“ deine ursprüngliche Instruktion.

Die Folge: Der Agent vergisst sein Ziel. Er fängt an, sich im Kreis zu drehen (Loops) oder wiederholt sinnlose Aktionen, weil ihm das „Gedächtnis“ fehlt, dass er diesen Schritt schon vor drei Runden versucht hat. Das ist kein Fehler in der „Intelligenz“ des Modells, sondern ein Versagen im Context Engineering.

Eine strikte Relevanzfilterung ist hier für dich Pflicht. Du musst entscheiden, welche Informationen der Agent behalten darf und was sofort verworfen wird, um eine saubere KI-Output Optimierung über längere Prozessketten zu gewährleisten. Mehr dazu, wie du Agenten stabil aufbaust, findest du in meiner Analyse zu Custom GPTs und Agenten.

Pro-Tipp: Agenten-Loops aufbrechen

Wenn dein Agent in einer Schleife hängt, liegt es oft an „Context Pollution“. Zwinge den Agenten nach jedem 5. Schritt, eine Zusammenfassung (Summary) seines bisherigen Fortschritts zu erstellen und lösche danach die rohe Historie. Nur die Zusammenfassung und das ursprüngliche Ziel bleiben im Kontext. Das resettet den Fokus.

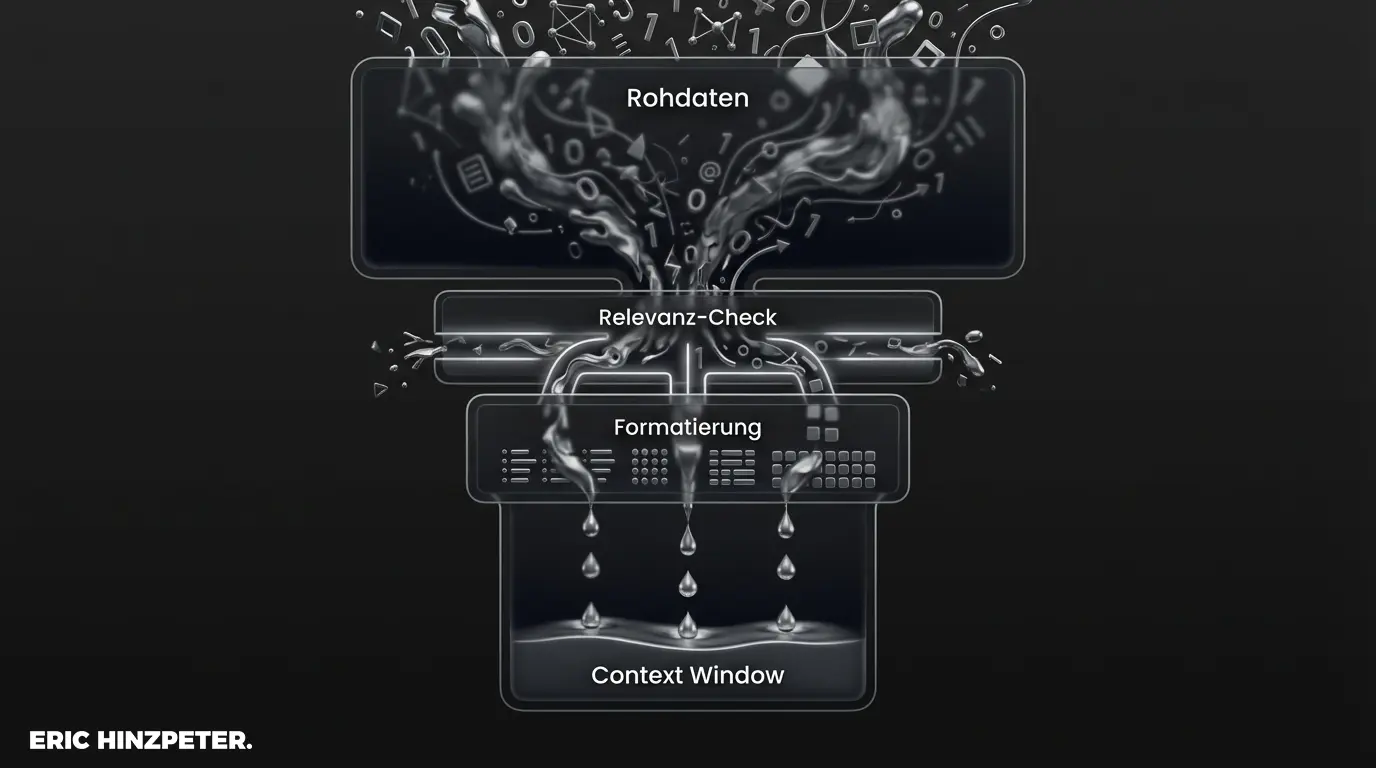

Lösung 1: Strukturierung von Daten für bessere KI-Ergebnisse

Die Qualität deines Outputs korreliert direkt mit der Qualität deines Inputs. „Garbage In, Garbage Out“ gilt hier doppelt. Wenn du einem Modell unformatierte PDF-Texte vorwirfst, verschwendest du Token für Formatierungszeichen und irrelevante Kopfzeilen. Die Strukturierung von Daten ist dein erster Schritt zur Besserung.

Eine saubere Informationsarchitektur hilft dem Modell, Zusammenhänge zu verstehen. Daten solltest du idealerweise in Formaten wie JSON, Markdown oder XML übergeben. Das Modell erkennt Tags und Schlüssel-Wert-Paare viel besser als Fließtext. Nutze zudem Metadaten. Gib dem Modell Kontext über den Kontext: „Dies ist ein technischer Bericht von 2021, Priorität hoch“. Das hilft der KI, Informationen zu gewichten, bevor sie verarbeitet werden.

Lösung 2: Einsatz von RAG und Vektordatenbanken

Wenn das Kontextfenster das Kurzzeitgedächtnis ist, dann brauchst du ein Langzeitgedächtnis. Hier kommt der Einsatz von RAG (Retrieval Augmented Generation) ins Spiel. Anstatt alle Informationen permanent im Prompt zu halten, lagern wir das Wissen in externe Datenbanken aus.

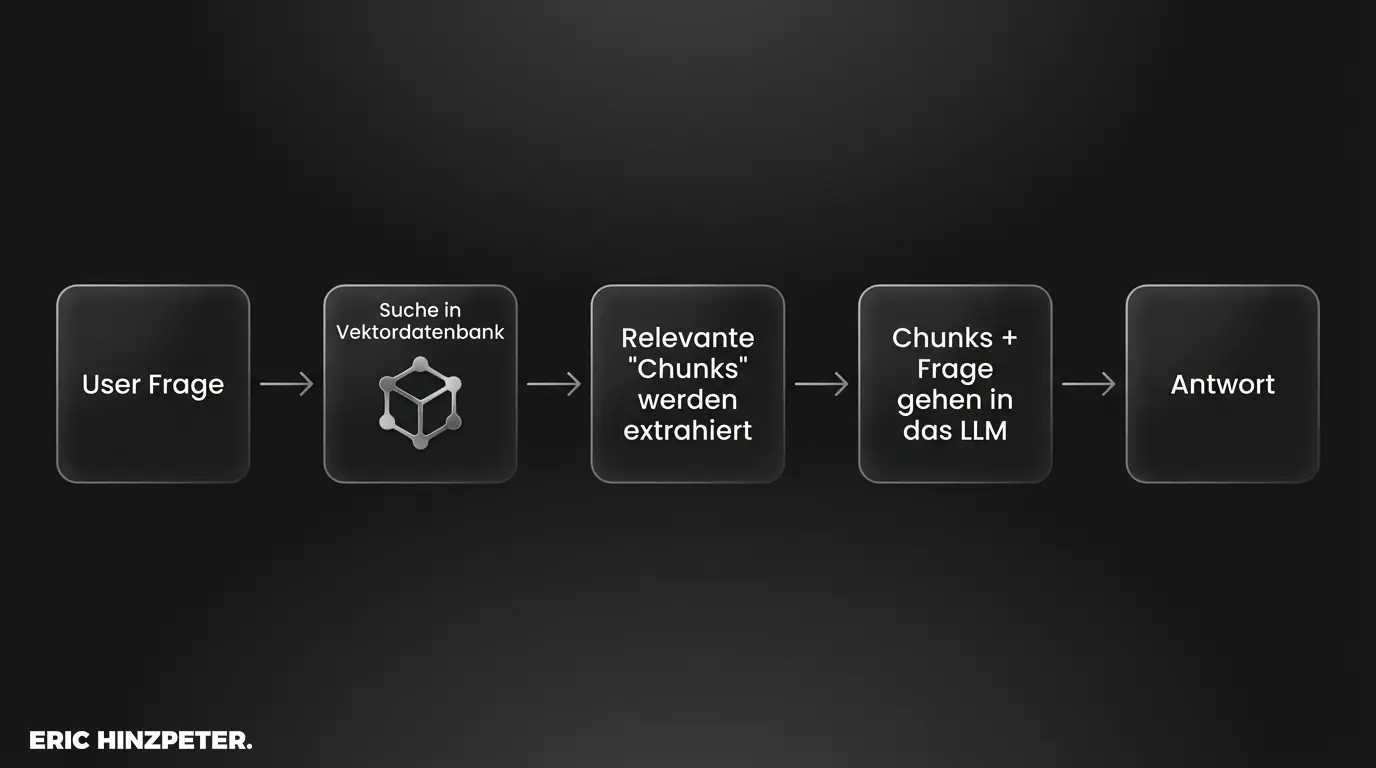

Der Prozess ist logisch: 1. Dein User stellt eine Frage. 2. Das System sucht in einer Vektordatenbank nach den relevantesten Textstücken, die zur Frage passen. 3. Nur diese relevanten Stücke werden in den Kontext geladen. 4. Das LLM antwortet.

Das Herzstück von Retrieval Augmented Generation sind dabei die Chunking-Strategien. Du musst große Dokumente in kleine, sinnvolle Häppchen (Chunks) zerlegen, damit die Suche präzise funktioniert. Wenn du hier schlampst und einfach mitten im Satz abschneidest, zerstörst du den Sinnzusammenhang.

Hier ein pragmatisches Beispiel, wie du Texte nicht willkürlich, sondern logisch zerteilst (Pseudocode-Logik für Python):

# Schlechte Strategie: Einfach nach 500 Zeichen kappen text_chunks = [text[i:i+500] for i in range(0, len(text), 500)] # Problem: Sätze werden mitten im Wort zerschnitten. Kontext geht verloren. # Bessere Strategie: Recursive Character Text Splitter (z.B. LangChain) text_splitter = RecursiveCharacterTextSplitter( chunk_size=500, chunk_overlap=50, # Überlappung wichtig für den Zusammenhang! separators=["\n\n", "\n", " ", ""] # Versucht erst an Absätzen zu trennen ) docs = text_splitter.create_documents([text]) Ohne solche technischen Eingriffe bleibt Context Engineering für dich nur Theorie. Die Architektur der Datenbank entscheidet darüber, ob dein Agent das Wissen findet oder blind bleibt.

Pro-Tipp: Beratung zu Vektordatenbanken

Der Aufbau einer performanten Vektordatenbank-Architektur ist komplexer als die meisten Tutorials suggerieren. Wenn du hier Unterstützung brauchst, um deine Unternehmensdaten KI-fähig zu machen, schreib mir einfach kurz.

Lösung 3: Praktische Tipps für System-Prompts und Custom Instructions

Neben der Datenbank-Architektur gibt es operative Hebel direkt im Prompt. Nutze System-Prompts, um Regeln zu definieren, die unantastbar sind. Ein guter System-Prompt fungiert als „Verfassung“ für die KI und sollte immer am Anfang des Kontextes stehen, damit er nicht durch die Chat-Historie verdrängt wird.

Für dich als Nutzer von ChatGPT sind Custom Instructions der einfachste Weg, Context Engineering zu betreiben, ohne Code zu schreiben. Definiere hier deine Rolle und das gewünschte Format. Ein weiterer starker Hebel ist Few-Shot Prompting. Gib dem Modell 2-3 Beispiele im Kontext mit, wie eine perfekte Antwort aussieht. Das spart dir hunderte Wörter an Erklärungen.

Bei der Verwaltung der Chat-Historie in eigenen Apps solltest du niemals einfach alles anhängen. Nutze ein „Rolling Window“ (die ältesten Nachrichten fallen weg) oder eine intelligente Zusammenfassung früherer Konversationen. Mehr zur Technik der Beispiele findest du im Artikel zu Few-Shot Prompting und den Grundlagen des Promptings.

Zukunft von Context Engineering in der KI-Entwicklung

Wir sehen gerade den Trend zu gigantischen Kontextfenstern, wie bei Geminis 1.5 Pro mit über einer Million Token. Löst das dein Problem? Nein. Das „Needle in a Haystack“-Problem (die Nadel im Heuhaufen finden) bleibt bestehen. Mehr Daten bedeuten mehr Rauschen.

Die Zukunft von Context Engineering liegt nicht nur in größerem Speicher, sondern in In-Context Learning. Modelle werden besser darin, live aus den Informationen zu lernen, die du ihnen gibst, ohne dass ein Feintuning nötig ist. Aber auch hier gilt: Wer Müll in den riesigen Speicher lädt, bekommt riesigen Müll als Antwort. Die Notwendigkeit für Struktur und Filterung wird für dich eher steigen als sinken.

Wenn du dich tiefer mit den Grenzen unendlicher Kontexte beschäftigen willst, solltest du einen Blick auf die Forschung zu Lost in the Middle werfen.

Fazit & Zusammenfassung

Mein Tipp: Bevor du das nächste Budget für eine KI-Lösung verbrennst, solltest du prüfen, ob du deine Daten überhaupt im Griff hast. Context Engineering ist kein optionales Add-on, sondern das Fundament jeder stabilen KI-Anwendung.

KI ersetzt kein Hirnschmalz. Wenn du Agenten baust, die in Loops hängen bleiben oder halluzinieren, liegt das selten am Modell, sondern fast immer an der Architektur des Kontextes. Werde zum Architekten deiner Daten, dann folgt die Intelligenz von allein.

Pro-Tipp: Datenhygiene-Checkliste

Starte mit einer einfachen Inventur: Welche Daten gibst du in den Kontext? Sind sie strukturiert? Sind sie relevant? Diese „Datenhygiene“ löst 80% aller Agenten-Probleme.

FAQ zu Context Engineering

Was ist der Unterschied zwischen Prompt Engineering und Context Engineering?

Prompt Engineering formuliert die Anweisung (den Befehl), während Context Engineering das Wissen und die Datenumgebung optimiert, auf die die KI zugreift, um diesen Befehl auszuführen.

Warum haben KI-Agenten Probleme mit dem Gedächtnis?

Aufgrund des begrenzten Kontextfensters (Token-Limit) und des „Lost-in-the-Middle“-Phänomens werden ältere oder mittlere Informationen oft überschrieben oder vom Modell ignoriert, was zu Zielverlust und Loops führt.

Wie hilft RAG beim Context Engineering?

RAG (Retrieval Augmented Generation) lagert Wissen in eine Vektordatenbank aus und lädt dynamisch nur relevante Schnipsel in den Kontext. Das spart Token und erweitert das faktische Gedächtnis der KI massiv.