In der Debatte um die Effizienz von Generative AI wird ein Aspekt oft übersehen: Die Qualität des Outputs hängt nicht primär von der Menge der Beispiele ab, sondern von der Logik der Instruktion. Zero Shot Prompting ist hierbei mehr als nur eine technische Definition – es ist der architektonische Härtetest für jedes Sprachmodell. Wer versteht, wie man eine KI ohne Sicherheitsnetz steuert, beherrscht das Fundament moderner Prompt-Architekturen.

Was ist Zero Shot Prompting?

Zero Shot Prompting bezeichnet eine Technik im Bereich der Künstlichen Intelligenz, bei der ein Large Language Model (LLM) eine Aufgabe lösen muss, ohne dass ihm im Prompt vorherige Beispiele (sogenannte „Shots“) zur Verfügung gestellt werden. Systemisch betrachtet basiert die Logik auf dem „Null-Versuch“-Prinzip: Das System erhält lediglich eine Instruktion und muss das Ergebnis rein auf Basis seines vorab trainierten Wissens generieren.

Im Gegensatz zu anderen Methoden ist im Prompt selbst kein Trainingsdatensatz oder Muster enthalten. Die Qualität des Outputs hängt bei dieser Methode fast ausschließlich von der Präzision der Formulierung und dem semantischen Verständnis des Modells ab. Die Struktur zeigt: Es ist die puristische Form der Interaktion mit einer KI.

In der Praxis bedeutet das: Du zeigst der KI nicht den Weg, indem du es vormachst, sondern definierst präzise das Ziel. Wenn du mehr über die grundlegende Struktur von Eingabebefehlen erfahren willst, lohnt sich ein Blick auf die Definition von einem Prompt.

Pro-Tipp: Startpunkt für jede Automation

Beginne jede neue Prompt-Entwicklung immer mit einem Zero-Shot-Ansatz. Teste erst, wie weit das Modell ohne Beispiele kommt. Oft wird die Baseline-Kompetenz aktueller Modelle unterschätzt. Füge erst dann Komplexität hinzu, wenn das Ergebnis ungenügend ist.

Wie funktioniert Zero Shot Prompting bei LLMs?

Um die Funktionsweise von Zero Shot Prompting zu verstehen, muss man die Architektur von Large Language Models betrachten. Diese Sprachmodelle sind nicht deterministisch programmiert, sondern arbeiten stochastisch. Sie berechnen die Wahrscheinlichkeit des nächsten Wortes basierend auf dem Kontext der Eingabe.

Obwohl im Prompt keine Beispiele enthalten sind, greifen Large Language Models auf ein immenses Reservoir an Mustern zurück, die sie während ihrer Trainingsphase gelernt haben. Die Trainingsdaten umfassen Milliarden von Texten, in denen Aufgabenstellungen wie „Übersetze“, „Fasse zusammen“ oder „Erkläre“ bereits unzählige Male vorkamen. Das Modell führt technisch gesehen eine Mustererkennung durch und mappt die neue Instruktion auf bekannte Konzepte aus dem Natural Language Processing.

Ein wichtiger Begriff hierbei ist das sogenannte In-Context Learning. Auch wenn explizit keine Beispiele gegeben werden, nutzt das Modell den Kontext der Instruktion selbst, um den latenten Raum seines Wissens zu aktivieren. Wer tiefer in die technische Verarbeitung von Eingaben einsteigen möchte, findet im Artikel über LLMs und Tokens weiterführende technische Details.

Für die wissenschaftliche Fundierung dieser Fähigkeit ist das Paper „Language Models are Zero-Shot Learners“ (verfügbar auf Arxiv.org) eine zentrale Referenz, die aufzeigt, wie Skalierung zu emergenten Fähigkeiten führt.

Die Rolle von Pre-trained Models und Kontext

Die Fähigkeit zum Zero Shot liegt im „Pre-training“ begründet. Ein Pre-trained Model hat bereits ein Weltverständnis aufgebaut. Wenn du die Anweisung gibst: „Schreibe eine E-Mail an einen Kunden“, muss das Modell nicht erst lernen, was eine E-Mail ist. Es ruft das Konzept „E-Mail“ und das Konzept „Kundenkommunikation“ ab und verknüpft diese logisch.

Der Kontext, den du lieferst, ist hierbei rein instruktional. Die semantische Dichte deiner Anweisung ersetzt die fehlenden Beispiele. Je besser das Modell „pre-trained“ ist, desto weniger Beispiele (Shots) benötigt es für komplexe Aufgaben. Das Prinzip ist klar: Das Modell transferiert Wissen aus dem Training auf die neue, unbekannte Aufgabe.

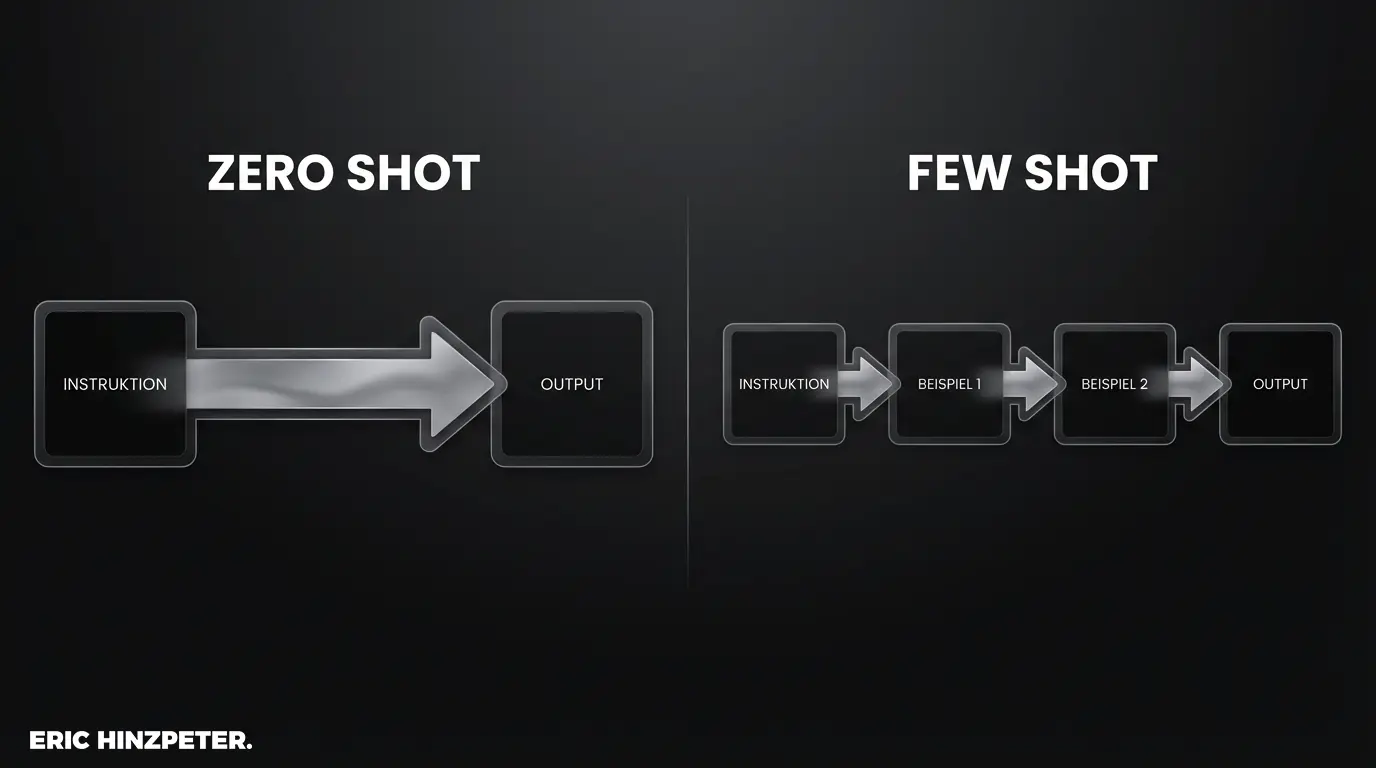

Unterschied zwischen Zero-Shot und Few-Shot Learning

Die Abgrenzung zu anderen Prompting-Techniken ist entscheidend für den Aufbau effizienter Workflows. Während Zero Shot ohne Sicherheitsnetz arbeitet, nutzt das Few Shot Learning mehrere Beispiele im Prompt, um das Modell auf ein spezifisches Muster zu „finetunen“ – allerdings nur im Rahmen des aktuellen Kontextfensters.

Zwischen diesen beiden Extremen liegt das One Shot Prompting, bei dem exakt ein Beispiel gegeben wird. Die Wahl der Methode ist eine Abwägung zwischen Effizienz (Token-Verbrauch) und Präzision. Zero Shot ist ideal für Aufgaben, die das Modell generell gut beherrscht. Few Shot Learning ist notwendig, wenn das Output-Format sehr spezifisch sein muss oder die Aufgabe eine Logik erfordert, die nicht im Standard-Training enthalten war. Mehr zur systematischen Optimierung findest du im Bereich Prompt Engineering.

Zero-Shot vs. One-Shot vs. Few-Shot

Die folgende Übersicht verdeutlicht die Unterschiede in der Architektur des Prompts:

| Methode | Anzahl Beispiele | Genauigkeit (bei Komplexität) | Aufwand im Prompting |

|---|---|---|---|

| Zero Shot | 0 | Mittel (hoch bei Standardaufgaben) | Gering |

| One Shot | 1 | Hoch (gibt Struktur vor) | Mittel |

| Few Shot | 2+ (meist 3-5) | Sehr Hoch (ideal für Muster) | Hoch |

Anwendungsbeispiele für Zero Shot Prompting

Die Theorie wird erst durch die Anwendung greifbar. Moderne Systeme wie ChatGPT (basierend auf GPT-4) zeigen beeindruckende Ergebnisse bei reinen Zero-Shot-Anfragen. Hier sind konkrete Beispiele für Textgenerierung und Aufgabenstellung, die ohne jegliche Beispiele funktionieren.

Pro-Tipp: Prompt-Bibliotheken anlegen

Speichere funktionierende Zero-Shot-Prompts als Templates ab. Da sie keine kontextspezifischen Beispiele enthalten, sind sie extrem wiederverwendbar und skalierbar für verschiedene Projekte.

Sentiment-Analyse und Klassifizierung

Klassifizierungsaufgaben gehören zu den Stärken von Large Language Models, da die Konzepte von Emotionen tief in den Daten verankert sind.

Prompt:

Klassifiziere den folgenden Text als positiv, negativ oder neutral: "Der Versand war extrem schnell, aber das Produkt kam beschädigt an." Antwort:Output:

NegativHier greift das Modell auf sein Verständnis von „beschädigt“ als dominantes negatives Merkmal zurück. Grundlagen dazu findest du auch in unserem Artikel zu Grundlagen des Promptings.

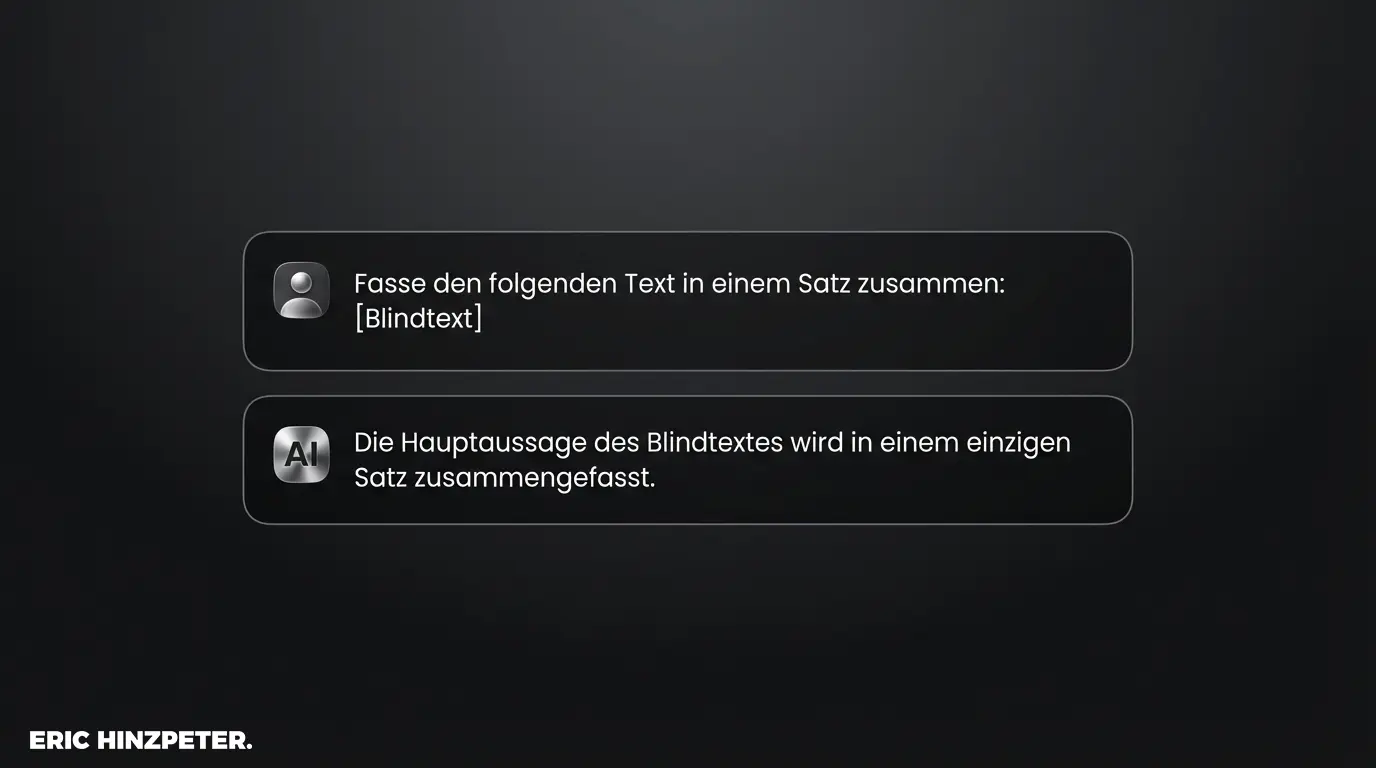

Textzusammenfassung und Übersetzung

Für Standardaufgaben ist Zero Shot oft der effizienteste Weg.

Prompt:

Übersetze den folgenden Satz ins Englische: "Die strategische Ausrichtung bestimmt den Erfolg der Kampagne."Output:

The strategic orientation determines the success of the campaign.Vorteile von Zero Shot Prompts: Grenzen und Herausforderungen

Systemisches Denken erfordert eine ehrliche Analyse. Die Vorteile von Zero Shot Prompts liegen auf der Hand: Sie sind schnell zu erstellen, verbrauchen weniger Tokens (was Kosten spart) und erfordern keine aufwendige Datenrecherche für passende Beispiele.

Doch es gibt klare Grenzen und Herausforderungen. Ohne Beispiele neigen Modelle eher zu Halluzinationen, wenn das Thema sehr nischig ist. Auch strikte Formatvorgaben (z.B. „Antworte nur als JSON ohne Text“) werden im Zero Shot Modus häufiger missachtet als im Few Shot Modus. Die Varianz der Ergebnisse ist höher, da der Interpretationsspielraum für das Modell größer ist.

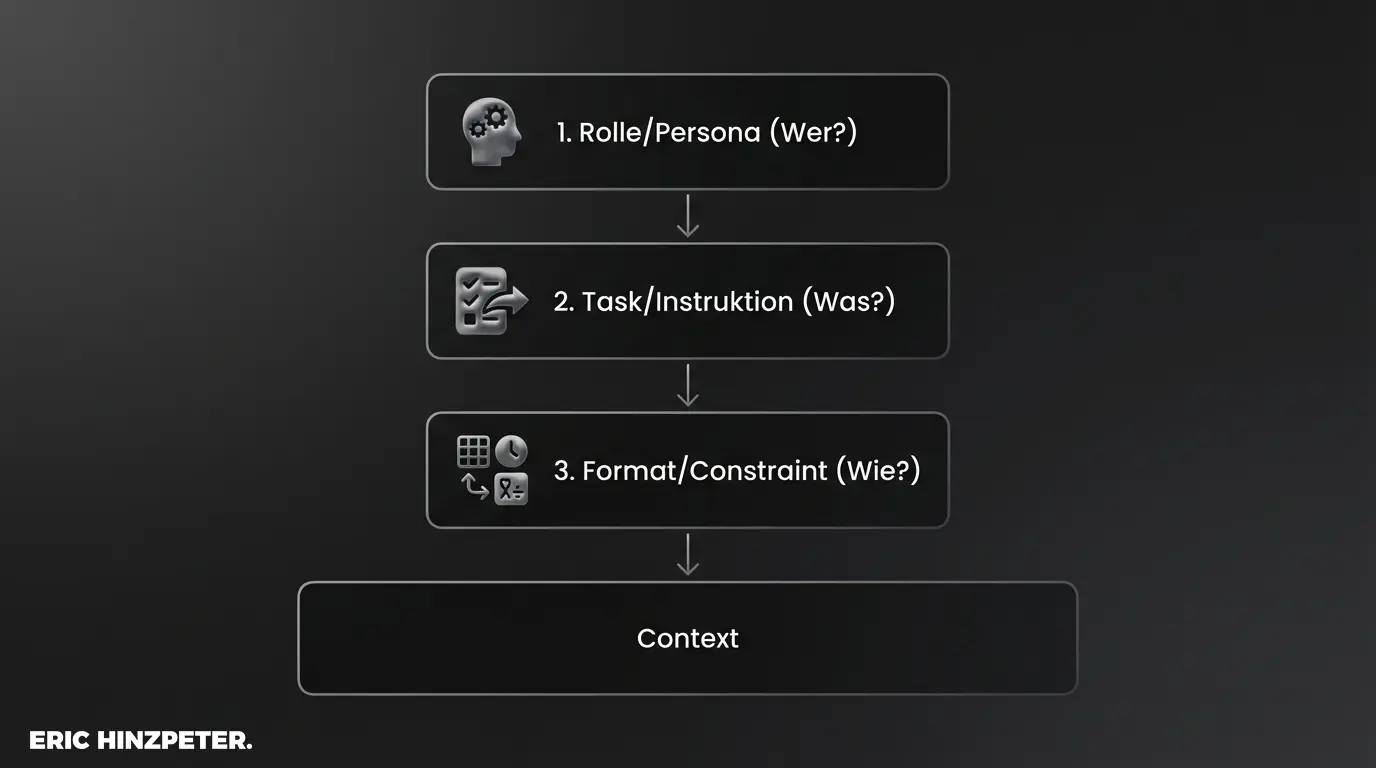

Tipps für effektives Zero Shot Prompt Engineering

Auch ohne Beispiele lässt sich die Qualität durch systematisches Prompt Design massiv steigern. Hier entscheidet die Klarheit der Instruktionen.

- Präzise Verben: Nutze starke Verben wie „Analysiere“, „Kategorisiere“ oder „Extrahiere“ statt „Mach mal“ oder „Schau dir an“.

- Persona-Zuweisung: Gib dem Modell eine Rolle. „Handle als Senior SEO Experte“. Dies aktiviert spezifische Bereiche im latenten Wissen des Modells.

- Chain of Thought: Auch Zero Shot funktioniert die Anweisung „Denke Schritt für Schritt“. Dies zwingt das Modell, seine interne Logik zu strukturieren, was die Modellantwort verbessert.

- Output-Format definieren: Beschreibe exakt, wie das Ergebnis aussehen soll.

Fortgeschrittene Techniken wie Custom GPTs nutzen oft komplexe System-Prompts, die im Kern aber auf perfektionierten Zero-Shot-Instruktionen basieren. Für tiefergehende Strategien lohnt sich oft ein Blick in Ressourcen wie den PromptingGuide.ai.

Fazit: Die Zukunft der Prompt-Technologien

Zero Shot Prompting ist nicht nur eine Einsteiger-Technik, sondern das Fundament jeder Interaktion mit LLMs. Während Few Shot Learning für komplexe Spezialfälle notwendig bleibt, entwickeln sich Modelle wie GPT-4 und Nachfolger immer weiter in Richtung perfekter Zero-Shot-Performance. Das Ziel der Entwicklung ist eine KI, die Intentionen so gut versteht, dass Beispiele überflüssig werden.

Die Logik der Anwendung entscheidet über den Erfolg. Wer die Prinzipien des Zero Shots meistert, baut effizientere, schnellere und kostengünstigere KI-Architekturen.

Pro-Tipp: Audit Ihrer Prompt-Architektur

Überprüfe regelmäßig deine Prompt-Bibliotheken. Ersetze komplexe Few-Shot-Prompts durch optimierte Zero-Shot-Instruktionen, sobald neue Modell-Generationen verfügbar sind. Das reduziert Latenz und Kosten.